Уведомления

Авторизуйтесь или зарегистрируйтесь, чтобы оценивать материалы, создавать записи и писать комментарии.

Авторизуясь, вы соглашаетесь с правилами пользования сайтом и даете согласие на обработку персональных данных.

Контроль над демонами: почему Маск и Возняк требуют остановить развитие ChatGPT

Двести лет назад люди боялись перенаселения, а еще вытеснения рабочих продвинутыми станками. Однако теперь вместо опасности перенаселения нам угрожает глобальный демографический спад, внедрение же станков закончилось резким ростом занятости в промышленности. Ныне главным пугалом человечества стал искусственный интеллект — именно с ним призывает бороться письмо за подписью Илона Маска. Стоит ли с ним бороться? Или, как в случае со станками и перенаселением, это приведет скорее к обратному эффекту? И что это будет за эффект? Naked Science пробует разобраться в вопросе.

Чего Илон Маск и другие технологические лидеры не понимают про ChatGPT?

В письме Института будущего жизни, которое подписал Илон Маск и многие другие лидеры высокотехнологичного сектора, утверждается: «Современные системы искусственного интеллекта теперь становятся способными конкурировать с людьми в задачах общего назначения. И мы должны спросить себя: Должны ли мы позволить машинам заполнить наши каналы распространения информации пропагандой и неправдой? Должны ли мы позволить автоматам отнять у нас все работы, включая те, что нас удовлетворяют? Должны ли мы развить нечеловеческие разумы, которые могут в конце концов превзойти нас в численности, уме, сделать нас устаревшими и заместить нас?»

Ответ напрашивается сам собой: ну конечно же, не должны. На этой основе Маск и все-все-все и предлагают на полгода приостановить разработку чат-ботов, по уровню превосходящих запущенную в марте 2023 года последнюю версию ChatGPT (четвертую). На первый взгляд это кажется ответственным поведением ответственных людей, много понимающих в развитии технологий.

Однако не исключено, что все это письмо — типичная ошибка, порожденная чрезмерно узкой специализацией его авторов. Начнем с главного: искусственного интеллекта не существует. Как совершенно верно отметила в 2021 году работавшая для Microsoft Кэйт Кроуфорд: «ИИ — это не искусственный, и не интеллект». Она развивает свою мысль: «С самого начала разработчики ИИ… мы сделали ужасную ошибку: поверили, что сознания — как компьютеры, и компьютеры — как сознание. Мы предположили, что эти штуки — аналог человеческого разума, но ничто не может быть дальше от истины».

Здесь стоит понять, почему. Представим, что есть нечто, что безусловно существует, но чью суть мы не понимаем — хотя пытаемся, потому что это явно мощная штука. Сделать это легко: например, в 1908 году над Сибирью рванул взрыв на десятки мегатонн, убивший троих человек. Вопрос: могли ли люди 1908 года воспроизвести его в том же году?

Ответ довольно прост: пока они не узнали, что это было и как научиться делать взрывы той же мощности, нет, не могли. На данный момент у ученых и философов нет никакого понимания, что такое естественный разум (интеллект), и даже определения, на котором бы большинство ученых сошлись. Почему?

Приведем пример такого определения: «разум (интеллект) — это способность воспринимать информацию или делать выводы из нее и запоминать ее как знание, которое можно применить в отношении адаптивного поведения в той или иной среде».

Любой биолог в этот момент рассмеется: получается, даже слизевик физарум многоглавый разумен. Еще 15 лет назад в эксперименте было показано, что он способен именно на то, что написано в цитате выше.

Тогда слизевика поместили вдоль дорожки в инкубаторе. Затем температурно-влажностные условия три раза — через равные промежутки времени — меняли на неблагоприятные для слизевика. С четвертого раза он начал адаптироваться: замедлял свои движения еще до наступления неблагоприятных условий. Если неблагоприятный режим вдруг не включали, через пару циклов слизевик забывал о нем. Все это соответствует определению «применять информацию для адаптивного поведения в новой среде».

Только вот есть проблема: у слизевика вообще нет мозгов. И нервных клеток тоже нет. Это миксомицет. Его обычная муха в плане когнитивных способностей превосходит сильнее, чем Эйнштейн — шимпанзе.

Как именно без нервной системы удается использовать информацию для адаптации, неизвестно. Но совершенно точно так же неизвестно, как это делаем мы.

Определений интеллекта было выдумано множество — более сотни. Однако все попытки применить их к реальности заканчивались таким же фиаско, что мы описали выше: «интеллект», выходит, был даже у растений, а то и у вовсе у природных процессов.

Однажды исследователи попробовали создать определение интеллекта, которое устроило бы всех. Правда, «всех» опять не вышло: под ним подписалось только 52 специалиста из 131 (то есть меньшинство), участвовавшего в выработке определения. Большинство отказались по очень простой причине: чтобы его нельзя было «натянуть» на деревья и прочую плесень, определение сделали максимально общим.

Оно прямо начиналось словами «Очень общая ментальная способность…» — и продолжалась примерно так же расплывчато. Пользы от него тоже нет: если в определении нет конкретики, а разум «определяется» как способность к абстрактному мышлению (при отсутствии определения термина «мышления»), то это определение уровня «конвергент есть продукт конвергенции». И оспорить такое трудно, и использовать невозможно.

Илон Маск и его единомышленники не замечают слона: если мы не можем выработать определение разумности, то мы не можем создать разум. Точнее можем, но только естественный, то есть путем биологического воспроизводства, без микросхем и программирования.

Но ведь ChatGPT разумен! Я знаю — сам разговаривал с ним

Сказанное выше кажется противоречащим тому, что каждый из нас легко может попробовать сам. А именно — опыту общения с чат-ботом GPT. Каждый может спросить его о законах Хаммурапи, видах на урожай на Шри-Ланке и получить разумный (ну э-э-э, по крайней мере, вам так покажется, если вы не очень пристально изучали Хаммурапи или Шри-Ланку) ответ.

Чтобы понять, почему кажущийся разумным чат-бот разумен умеренно, можно вспомнить собственное детство. Вот вы учите таблицу умножения, и родители спрашивают ее у вас. Видя, что у вас получается, они задают вопросы типа: сколько будет 89 на 94? Поскрипев мозгами секунд десять, вы выдаете ответ.

Вопрос: создали ли вы при этом что-то принципиально новое? Ответ: нет. ChatGPT — это большая языковая модель, натренированная на огромной выборке из массивов слов. Представим, что вы залили в некую базу данных все книги, написанные человечеством, плюс все, написанное людьми в интернете. Разбили (людьми ли, нейросетью-классификатором ли, неважно) залитое на небольшие тематические блоки, каждый из которых можно рассматривать как кусочек ответа на вопрос. Затем задали определенные правила — назовем их «четыре арифметических правила для чат-бота», — по которым эти тематические блоки можно смешивать.

ChatGPT будет делать ровно то, что и дошкольник в ответ на вопрос родителей «сколько будет 89 на 94». Это просто механическое следование определенному натаскиванию, которое шло по заранее определенным правилам. Не более. Таблица умножения с триллионами вариантов ответов, которая требует огромной памяти, но ни капли интеллекта.

В сущности, каждый из нас уже видел ChatGPT — еще до его изобретения. Это случалось тогда, когда вы или ваш одноклассник (однокурсник) не подготовились к занятию или экзамену, а двойку получать не хочется. И в ответ на вопрос преподавателя «как вы определите отличие бинарной логики и небинарной», начинали «сочинять».

Выдавали собственные попытки оттолкнуться от смысла отдельных слов: бинарная — ага, состоящая из двух частей, или двоичная, так-так, главное говорить и не останавливаться. В гуманитарных предметах преподаватель останавливает такой поток красноречия медленнее, в естественных — быстрее, но опытный преподаватель отличит «сочинителя» всегда. Его легко выдает отсутствие конкретики.

Отличие ChatGPT от студента из примера выше в том, что у чат-бота в «памяти» сидит несопоставимо больший набор тематических блоков на любые темы. Перед нами ходячая шпаргалка: выражаясь студенческим языком, у ChatGPT есть «бомба» на все вопросы, которые хотя бы примерно пришли в голову его создателям при разметке данных. Если таких «бомб» у него триллион, то в большинстве случаев, разговаривая на не очень сложные темы, отличить чат-бота от человека реально не получится.

Именно этим и пользуются многие хитрые хомо сапиенсы. Кто-то «пишет» чат-ботом в соцсети для знакомств с противоположным полом. Ну какая девушка сразу спросит у вас, почему в законах Хаммурапи выбрана такая высокая отсекающая кредитная ставка? Подобных вопросов на свидании можно и за всю жизнь не услышать, зато «ответы» от чат-бота действительно поднимают шанс получить от собеседницы (или собеседника) «да».

Только вот к разуму такие обмены репликами не имеют никакого отношения. Приложение для игры в шахматы на вашем телефоне тоже может рассчитать бесчисленное количество ходов. Но значит ли это, что вы должны опасаться захвата им господства над миром?

Но ведь он лишит нас рабочих мест!

Тут сразу надо заметить, что большинство существующих рабочих мест не могут быть автоматизированы ни в какой перспективе — вопреки тому, что написано в письме с подписями Маска и Возняка. Собственно, сам Илон Маск это неплохо знает: его попытка создать автоматизированное производство Tesla Model 3 в 2018 году провалилась. Производственные линии пришлось срочно переделывать «под людей», потому что оказалось, что без брака многие сложные операции им удаются, а роботам — нет. Именно тогда Маск и произнес свои исторические слова: «Людей серьезно недооценивают как работников».

Почему так получается? Основная причина не только в том, что у наших пальцев десятки степеней свободы, а у роботов столько степеней свободы будут стоить слишком дорого. Дело именно в интеллекте — который у нас есть, а у роботов — нет. Чтобы вам удавались ловкие движения, вы должны не просто понимать, как двигаться, но и адаптироваться к быстро меняющимся условиям. Роботы — и под управлением нейросетей тоже — пока справляются с этим, только если их долго и упорно «натаскивать» на движения определенных типов. Но производственные процессы всегда состоят не только из простых движений.

Поэтому попытки создать роботов, собирающих томаты или строящих дома, заканчиваются тем, что за машиной идет человек, собирающий оставшиеся овощи или убирающий раствор, наляпанный роботом.

Управлять манипуляторами робота компьютеру несопоставимо сложнее, чем вытаскивать из памяти «бомбы» (тематические блоки на заданные темы), как неуспевающий студент на экзамене. Набор «бомб» численно мал, и если робот ошибется с ними так, как на иллюстрациях, все, что его ждет, — легкое неудовольствие собеседника. А вот если так же ошибется промышленный робот, будет брак. И хорошо, если в итоге не погибнут люди.

Поэтому в реальности ChatGPT и его аналоги может повлиять в основном на работу «белых воротничков». Программисты уже показывают примеры того, как им удалось написать простое приложение для телефона, только отдавая приказы чат-боту. Проблема даже не в том, что пока написанные ими приложения по сложности напоминают программу для игры в крестики-нолики, которые в 1990-е российских школьников учили писать на «бейсике». Это как раз можно поправить.

Проблема в другом: любой, хоть что-то понимающий в программировании, легко заметит, что ChatGPT на самом деле сам ничего не пишет. Программирует он так же, как отвечает на вопрос о Хаммурапи: тупо достает и комбинирует «бомбы» из своей памяти. Стандартные задачи «из учебника» по коду он вполне «вывезет».

Что-то сложное? Правка бага, возникшего потому, что ваше приложение не работает под нетипичной операционкой, которую очень хочет клиент, но которая черт его знает, как работает? С этим чат-бот не справится. И с олимпиадными задачами по программированию он вам тоже не поможет.

Некоторые думают, что это очень просто поправить. Добавить в память ChatGPT примеры нетипичных задач и… И ничего. Нетипичные задачи характеризуются тем, что они непохожи даже друг на друга. Одно дело — давать ответы на вопросы из таблицы умножения, даже если вместо 2 и 2 вы подставите 343 859 и 275 875. Совсем другое — думать. Для задач первого типа компьютеры подходят идеально: думать не надо, только идти по алгоритму, заданному хоть программистом, хоть машинным обучением, без разницы.

Для задач второго типа компьютеры не годятся: думать им нечем. И если слизевика или муравья хотя бы не надо обучать тому, как реагировать на новую задачу (они и сами учатся — смотри выше), то с искусственным «интеллектом» так не получится. Выполняя задачи сходного типа в другой области он еще справится, но на нетипичных задачах будет «сыпаться», как старинный 286-й, которого вы попросите доказать теорему Ферма.

Что на самом деле ему под силу

Пятнадцать лет назад автору этих строк впервые показали автопереводчик. Было невыносимо смешно. Несколько лет назад ему пришлось редактировать книги, переведенные с английского, предположительно людьми. Пройдя пару сотен страниц, он нашел пару десятков однотипных ошибок, которые не мог сделать человек-переводчик. Пришлось заинтересоваться вопросом и пообщаться с профессиональными переводчиками на условиях полной анонимности.

Выяснилось следующее. Российские издательства платят за переводы книг настолько ничтожные деньги, что переводить за них так, как это делали переводчики братья Стругацкие, невозможно: жить будет не на что. Поэтому переводчики с этого рынка либо ушли, либо превратились в редакторов того, что им выдает продвинутый автоперевод (системы, на голову выше не то что гугл-переводчика, но и DeepL). Запустив туда текст книги, «переводчик» затем лишь просматривает получившееся на предмет типовых ошибок автоперевода (они все еще есть, просто их не так много).

Разумеется, издателям этого никто не говорит: переводчик до последнего будет уверять, что никогда так не делает. На практике так делают практически все. Те, кто не хочет, постепенно уходят из отрасли, потому что иначе их доходы упадут ниже уровня московского дворника. Реальная цена на час труда переводчика не упала — просто теперь они все своего рода «СhаtGPT». Ну а если вам хочется хорошего слога (как у Стругацких в «Дне триффидов»), то вы можете почитать книжку и в оригинале, рассуждают переводчики в наше время.

Та же судьба ждет и новый чат-бот. Ничего не умеющие младшие программисты постепенно втянутся использовать его для стандартизированных задач. Ничего не умеющие копирайтеры, сочиняющие новости, не имеющие отношения к реальности, тоже будут использовать его. И это, в общем-то, хорошо. Почему?

Потому что текущий уровень большинства специалистов в «написании букв» ужасен настолько, что ChatGPT тут ничего не ухудшит, а, скорее всего, даже улучшит. Простейший пример, с которым мы на Naked Science сталкиваемся каждый день, «научные новости».

Не будем спускаться на дно: возьмем не самый худший пример из текущий недели: новость Associated Press о том, что китайские ученые обнаружили новый источник воды на Луне.

В новости есть ссылка на работу в Nature Geoscience, по которой она написана. В работе, однако, нет ничего о том, что ее авторы открыли какой-то новый источник воды. Нет таких заявлений и в словах авторов работы, с которыми переговорили журналисты AP. И это логично: наличие воды на Селене открыли не они, и сделано это было давно. Но из новости Associated Press этого не узнать. В таком же виде и с тем же ложным выводом ее подали и в российских СМИ (Naked Science разбирал это здесь).

Мы провели эксперимент и поручили написать новость про то же самое ChatGPT. И что в итоге? Конечно, получилось плохо: лунная «почва» (на Луне нет почвы), «стеклянные шары» и тому подобное. Однако многие СМИ, где пишут люди, осветили ту же новость как минимум не лучше.

Но главное, что ChatGPT не допустил абсолютно ложного утверждения, которое появилось в новости AP и всех, кто его бездумно переписал: «В образцах с Луны обнаружили новый возобновляемый источник воды».

Случаев, подобных такой новости, очень и очень много. Ведь в качественных новостях заинтересован лишь потребитель. Но он как раз на работу СМИ никак не влияет: он ее не оплачивает (кроме редких случаев подписных изданий). А те, кто ее оплачивают (рекламодатели), СМИ за пределами рекламных материалов не особенно и читают.

В том, что ChatGPT вытеснит из профессии людей, пересказывающих научные статьи в формате испорченного телефона, нет ничего плохого. Работу таких журналистов вполне можно считать деструктивной и общественно опасной деятельностью. Чат-бот просто снизит уровень ее опасности для мозгов читателей — не более.

Еще более полезно будет его появление в мире текстов рекламных, в котором требования к авторам текстов еще ниже, чем в типичном СМИ. А ChatGPT тренировали на выборке, прошедшей хотя бы минимальный отбор на качество языка. Да, он напишет как троечник, но не как двоечник же. А значит, качество рекламных текстов неизбежно вырастет.

По этой же причине не стоит волноваться, как это делают авторы все того же письма, что машины наполнят «наши каналы распространения информации пропагандой и неправдой». Откройте глаза и оглянитесь: это уже случилось. Откройте газету, которую вы читаете по утрам: с большой долей вероятности она переполнена «пропагандой и неправдой».

Причем неправда и пропаганда сделаны так же плохо и неумело, как и научные новости про «новый источник воды на Луне». Потому что их пишут те же ничего не умеющие и малооплачиваемые люди.

В этом и есть главная ошибка подписавших письмо Маска, Возняка и остальных взволнованных граждан. Они протестуют против явления, которое не сможет испортить мир вокруг нас по той простой причине, что планета и до ChatGPT была «для веселья мало оборудована».

Так ради чего мы должны задерживать развитие ChatGPT? Чтобы еще шесть месяцев наслаждаться «новыми источниками лунной воды», которых никто не открывал?

Чего на самом деле стоит ждать от ChatGPT?

Как и множество инструментов компьютерной эры до того, ChatGPT и ему подобные — не «новый разумный вид»: в плане критериев разумности он отстает даже от слизевика (нет использования полученной информации для адаптации в принципиально новых условиях). Зато это, безусловно, отличный инструмент — что-то типа пневмомолотка или станка ЧПУ. Забивать гвозди можно и вручную, но вам придется тратить намного больше сил или забивать намного меньше гвоздей в час.

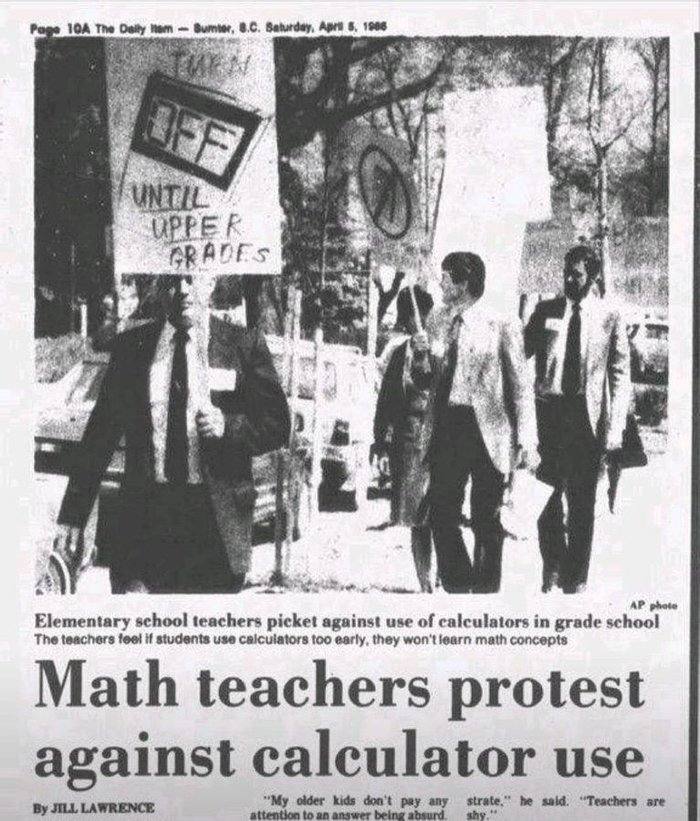

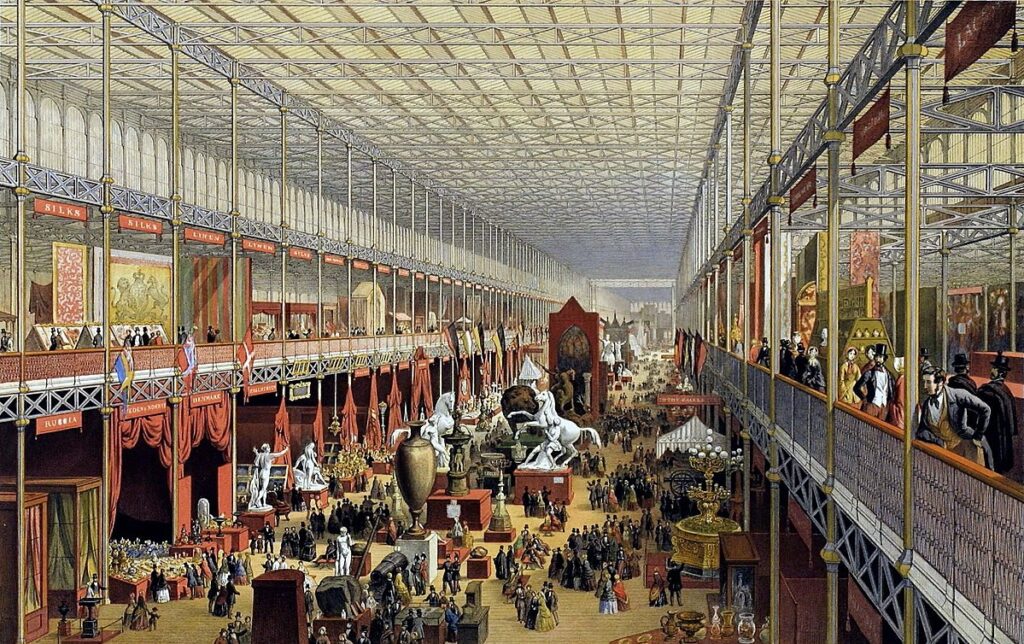

Нам еще в школе рассказали о том, как станки действуют на рабочие места, и рассказали неправильно. Напомним типичную канву таких рассказов: продвинутые ткацкие станки в XVIII веке сделали безработными индийских ткачей, и те умерли от голода.

Потом нам рассказывают о техническом прогрессе, роботах и компьютерах, и мы как-то почти сами собой приходим к выводу, что дальше машины вытеснят человека и из других рабочих специальностей. Это звучит тревожно: у кого-то в школе преподают экономику, где рассказывают, что рабочие получают в среднем больше других наемных работников, и по этой причине сокращение рабочих мест в промышленности в Штатах считают одним из признаков деградации структуры занятости в этой стране.

На самом деле, истории про «вытеснение индийских ткачей машинами» попали в наши учебники из поверхностной околоэкономической литературы XIX века. В реальности все было совсем не так.

Во-первых, Англия конкурировала с индийцами, ввозя хлопок из Индии для переработки у себя, но при этом запрещая импорт готовых изделий. Во-вторых, изобретение автоматизированных ткацких станков на самом деле вовсе не вытеснило труд индийцев: оно случилось в XVIII веке, а реальное замещение индийского текстиля британским произошло только после начала наполеоновских войн.

В-третьих — и это самое важное, проблема индийских ткачей была вовсе не в том, что они не могли конкурировать с новыми британскими станками. А в том, что Британская Ост-Индская компания установила нерыночные, директивные — и на 20% ниже себестоимости — цены на изделия индийских ткачей. Параллельно она же установила жесткое квотирование количества хлопка-сырья, которое они могли получить. А всё, что сверх того, отправляли в Британию.

Нельзя сказать, чтобы индийцы не пытались что-то сделать. Отдельные ткачи пробовали продавать свою продукцию не Ост-Индской компании, а другим покупателям, но это у них плохо получалось. Процитируем здесь англичан, наблюдавших все это: «Агенты компании часто захватывали и бросали в тюрьму ткачей [пытавшихся продавать не компании], держали их в кандалах». Ткачи, работавшие с шелком, наказывались иначе: «Были известны случаи отрезания им больших пальцев».

Индийские ткачи проиграли конкуренцию не британским станкам, а британским топорам, которые отрубали им пальцы, и британским кандалам, в которых их держали, если они пробовали конкурировать со станками на рыночных началах.

Казалось бы, не все ли равно, как оно там было двести лет назад? Нет, не все равно. Всегда следует помнить: появление средств автоматизации почти всегда ведет к росту занятости, а не к ее падению. Почему?

Когда один ткач начинает выполнять работу ста ткачей, цена одежды резко снижается. До появления ткацких станков сотни миллионов людей использовало в основном «домотканные» вещи. Еще в 1920-х в СССР премировали людей «мануфактурой» — то есть тканью фабричного производства, которая для большинства крестьян обычно была недоступна. Ручные прялки были атрибутом чуть не каждого сельского дома в стране.

Массовое производство уронило цены на одежду до уровня, когда «домотканая» одежда просто не имеет смысла. Более того: снижение цен на массовые вещи привело к возможности часто менять их, следуя за модой.

В итоге «вымирания ткачей» не просто не случилось: станки резко умножили их число. Напомним цифры: Индия 1700 года (включала земли современного Пакистана и Бангладеш) имела 150 миллионов населения, экспортировала 25 процентов от всего текстильного вывоза на планете. За счет отрубания пальцев, монопольной скупки и других достижений британской цивилизации к 1947 году эта доля упала до двух процентов.

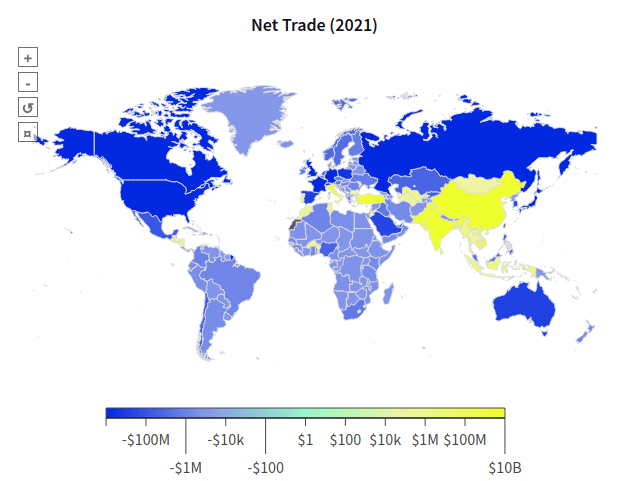

Но стоило индийцам лишиться заботливого белого господина, и внезапно оказалось, что станки им не только не мешают, но и помогают. В современной Индии + Пакистане + Бангладеш совокупно более 50 миллионов работников текстильной индустрии. Это во много раз больше, чем 300 лет назад, то есть даже на душу населения «ткачей» в Индии, скорее всего, стало даже больше.

В основном они обслуживают внутренний рынок: даже бедные слои населения не делают себе одежду сами, как это было 300 лет назад. Но и экспорт там весьма значительный.

Что самое интересное: как только сахиб покинул индийцев, немедленно оказалось, что даже сектор, все еще работающий ручными прялками, внезапно конкурентоспособен. Они делают одежду, не похожую на заводскую, что поднимает ее цену достаточно, чтобы индийские ткачи вполне могли на этом заработать.

Пример с ткацкой индустрией очень показательный. Даже если ChatGPT научится стандартному программированию не ради хайпа, как сейчас, а реально производительному, он не заменит программистов. Лишь позволит им выпускать больше кода в единицу времени, редактируя код, а не набирая его с нуля. И, разумеется, в нестандартных задачах всегда будет «спрос на ручной труд», по той простой причине, что впихнуть все типы задач в обучающую выборку всегда будет слишком дорого. Как слишком дорого придавать индивидуальный дизайн вещам с текстильных фабрик, за счет чего и существуют индийские ткачи, работающие вручную.

То же самое касается и остальных белых воротничков. ChatGPT «пишет» (а точнее, комбинирует заложенные в него при обучении наборы слов), мягко говоря, так себе: слог далек от приятного. Понять, о чем он пишет, чат-бот не может принципиально, потому что понимать некому. У него нет своей личности, он может только комбинировать символы по заданным правилам. Следовательно, его «статьи» всегда будут глубоко вторичны и не более содержательны, чем плохая статья из Википедии.

В таких условиях рынок статей будет забит двумя видами продукции. Низкокачественным итогом работы редакторов выдачи ChatGPT и тем, что написано людьми, вручную.

Запреты: бесполезны или вредны?

Билл Гейтс говорил: «Я согласен с Илоном Маском и другими в этом, и не понимаю, почему некоторые люди не обеспокоены [искусственным интеллектом]».

Илон Маск высказался еще более конкретно: «Самая большая угроза нашему существованию, вероятно, искусственный интеллект… должен быть регуляторный надзор, может быть, на государственном или международном уровне. С ИИ мы вызываем демона. В историях о вызывании демона фигурируют пентаграммы и святая вода, которые удерживают его под контролем. Вы знаете, это не сработало».

Мы не Илон Маск, но одно можем сказать точно: все исторические попытки поставить под контроль развитие новых технологий заканчивались очень печально.

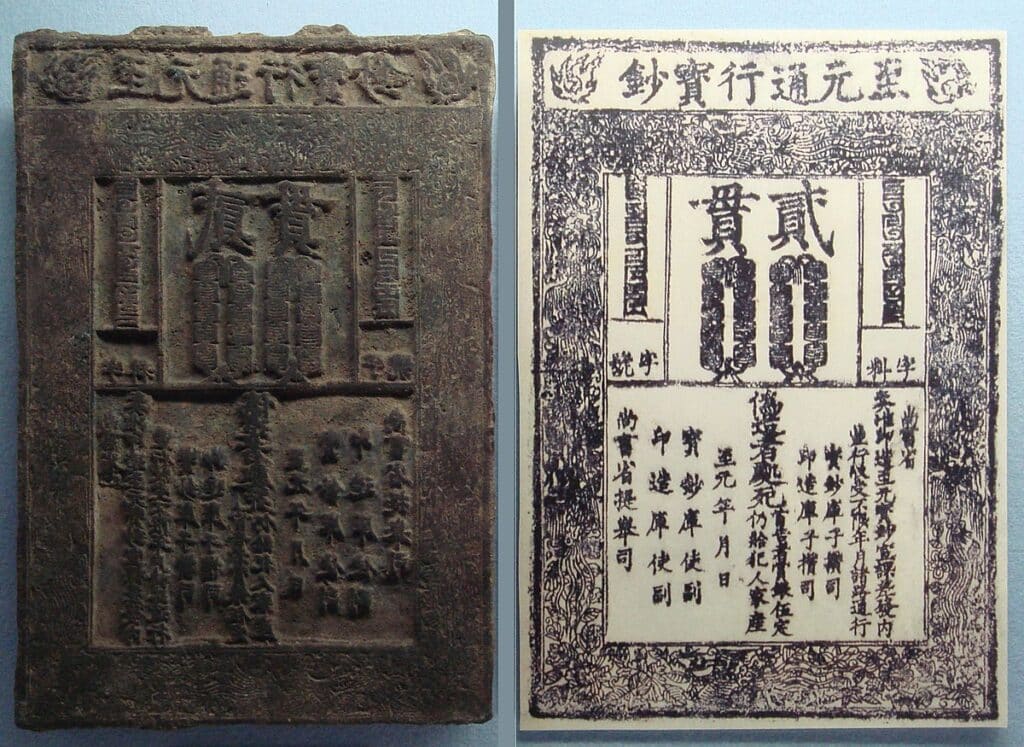

Все мы хорошо знаем этот пример. К XIV веку китайцы уже использовали пороховую артиллерию, печатный станок, туалетную бумагу, банкноты, перегонный куб, йод как антисептик и прививки от оспы. Еще они владели такой сложной технологией, как массовая постройка громадных (даже по современным меркам) кораблей с румпелями и водонепроницамемыми переборками, пригодными для трансокеанских плаваний.

Ничего из этого европейцы той эпохи не разработали. Те же корабли Колумба были небольшими, легко тонущими, в среднем очень мало служившими.

Но Китай, как и многие сегодня, не хотел «вызывать демонов», потому что опасался, что не сможет их контролировать. Пороховое оружие подвергалось жесткому госконтролю и ограничениям — как и войны, которые так способствовали его развитию в Европе.

Банкноты — до массового безналичного расчета необходимая часть любого длительного и сильного экономического роста — были просто запрещены династией Цин. Из совершенно благих соображений: чтобы не вызывать гиперинфляции, получившейся у прежних династий. И строительство крупных кораблей там тоже запретили: ведь на них возили контрабанду, да еще и пиратствовали.

Из этого легко видно, почему европейцы, начавшие с куда более худших стартовых условий, приплыли в Китай и практически уничтожили древнейшее из существующих государств планеты.

Иначе просто не могло быть. Если одна сторона не налагает ограничений на развитие оружия и кораблей, а вторая «не вызывает демонов», то у первой они неизбежно будут лучше, чем у вторых.

Если одна сторона не может долго и быстро наращивать ВВП (поскольку металлические валюты этого технически не позволяют), а другая может (сперва за счет прилива металлов из Нового Света, а затем и печати денег), то экономика второй со временем неизбежно станет намного больше.

Позиция Маска, Возняка и других выглядит разумной и обоснованной. Точно так же, как китайские запреты на пороховые мины, фиатные деньги и прочие сложные технологии и оружие.

Вот только и Маску, и Гейтсу с Возняком стоит помнить: тот, кто не хочет вызывать демонов сам, обречен на то, чтобы бороться с демонами, которых вызовут другие.

Да, никакого искусственного интеллекта не существует, и ChatGPT сам вам это напишет, если вы его спросите. Но точно так же не было интеллекта и у продвинутых ткацких станков XVIII века или у самостоятельно взрывающихся контактных китайских мин XV века. И, тем не менее, они были очень эффективными приспособлениями, дававшими своим создателям преимущества над теми, у кого таких технологий не было.

Приостанавливать развитие «искусственного интеллекта» в связи с этим — двойная ошибка. Во-первых, недальновидно пытаться контролировать демонов, которых не существует. Во-вторых, вдвойне недальновидно пытаться мешать возникнуть своим «псевдодемонам», если в результате вам придется отбиваться от чужих.

Астрономы недавно проанализировали базу данных о падающих на Землю объектах и пришли к выводу, что два из них прибыли из межзвездного пространства. Известна не только дата, но и место падения каждого из них.

На наземные растения, в основном деревья, приходится 80 процентов всей биомассы Земли, 450 миллиардов тонн сухого углерода и более двух триллионов тонн «живого веса». Поэтому идея сажать новые леса для связывания СО2 из атмосферы долго казалась логичной. Новые данные показали, что реальность заметно сложнее.

Приблизительно 4,5 тысячи лет назад в Британии произошла быстрая и масштабная смена населения. Неолитические народы, построившие Стоунхендж и большинство других памятников, практически исчезли, их заменили представители другой культуры. Долгое время археологи спорили, откуда пришли новые люди, которым так быстро удалось покорить остров. Ответ нашла международная команда генетиков.

Астрономы недавно проанализировали базу данных о падающих на Землю объектах и пришли к выводу, что два из них прибыли из межзвездного пространства. Известна не только дата, но и место падения каждого из них.

«Любить лишь можно только раз», — писал поэт Сергей Есенин, а герои культовых сериалов приходили к выводу, что «настоящая» влюбленность случается в жизни максимум дважды. Однако ни один из этих тезисов не подкреплен научными данными. Американские исследователи подошли к вопросу иначе: опросили более 10 тысяч человек и вывели среднее число сильных влюбленностей, возможных в течение жизни.

17 февраля 2026 года произойдет первое в этом году солнечное затмение, которое будет иметь кольцеобразный тип. Ученый Пермского Политеха Евгений Бурмистров рассказал, почему февральское затмение не похоже ни на одно другое, когда его ожидать и кому посчастливится стать свидетелем редчайшего «огненного кольца».

Астрономы недавно проанализировали базу данных о падающих на Землю объектах и пришли к выводу, что два из них прибыли из межзвездного пространства. Известна не только дата, но и место падения каждого из них.

Международная команда палеонтологов описала новый вид динозавра размером с крупную современную птицу. Он носил на голове плотный костяной нарост, который эти животные, возможно, использовали для внутривидовых разборок. Находка показывает, что даже мелкие хищники мелового периода могли решать конфликты не только когтями и зубами, но и ударами головой.

Образцы грунта, взятые астронавтами полвека назад, вложили еще один важный кирпич в здание научной картины мира: гипотеза о том, что Земля исходно была сухой, не стыкуется с фактами. Похоже, идею о невозможности сохранения большого количества воды на «теплых» планетах придется пересмотреть.

Вы попытались написать запрещенную фразу или вас забанили за частые нарушения.

Понятно

Из-за нарушений правил сайта на ваш аккаунт были наложены ограничения. Если это ошибка, напишите нам.

Понятно

Наши фильтры обнаружили в ваших действиях признаки накрутки. Отдохните немного и вернитесь к нам позже.

Понятно

Мы скоро изучим заявку и свяжемся с Вами по указанной почте в случае положительного исхода. Спасибо за интерес к проекту.

Понятно

Последние комментарии