Этот пост добавлен читателем Naked Science в раздел «Сообщество». Узнайте как это сделать по ссылке.

Уведомления

Авторизуйтесь или зарегистрируйтесь, чтобы оценивать материалы, создавать записи и писать комментарии.

Авторизуясь, вы соглашаетесь с правилами пользования сайтом и даете согласие на обработку персональных данных.

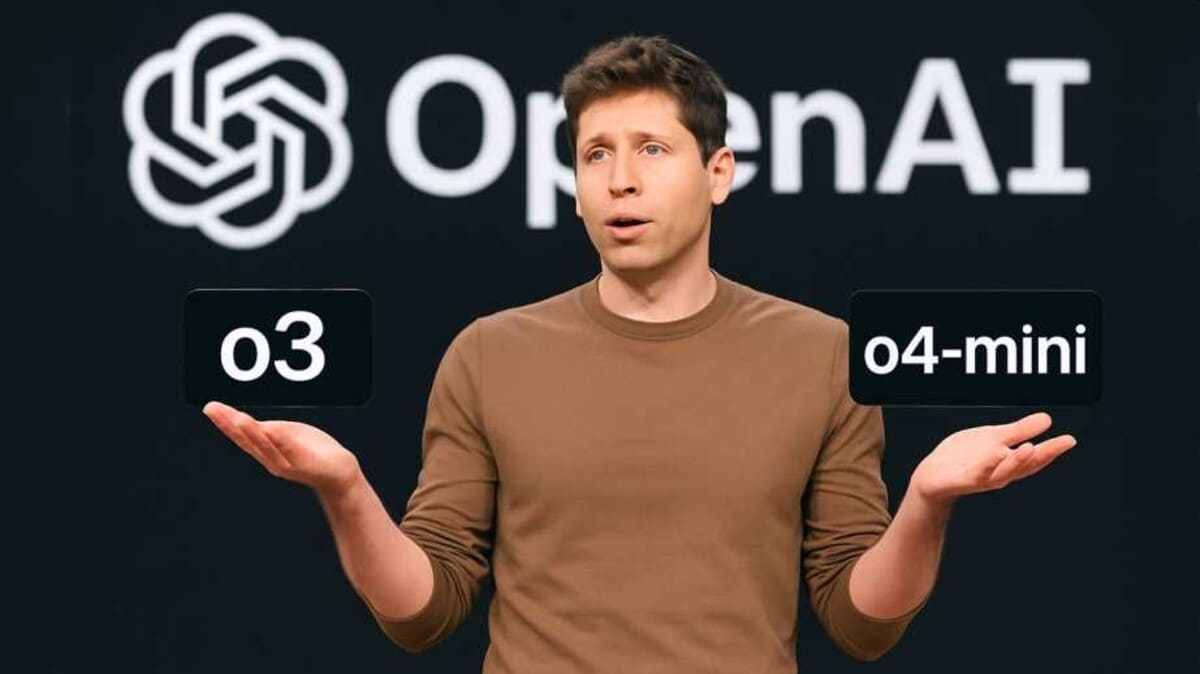

Разработчики признались, что не понимают, почему новые ИИ стали ошибаться чаще, чем их предшественники

На прошлой неделе американская технологическая компания OpenAI представила новейшие большие языковые модели искусственного интеллекта, получившие названия o3 и o4-mini.

Однако, как показали тесты o3 и o4-mini, по-видимому, сделали значительный шаг назад: они склонны придумывать — или «галлюцинировать» — сильнее, чем их более ранние версии.

По данным издания TechCrunch, новые модели OpenAI противоречат исторической тенденции, согласно которой каждая новая модель давала все меньше галлюцинаций, чем предыдущая, что позволяет предположить, что OpenAI теперь движется в неверном направлении.

Согласно результатам внутреннего тестирования OpenAI, o3 и o4-mini склонны к галлюцинациям чаще, чем старые модели, включая o1, o1-mini и даже o3-mini. Модель o3 выдала 33% ошибок на тесте точности компании. Это примерно вдвое больше, чем у предыдущих моделей OpenAI. Тогда, как o4-mini показала еще более худший результат — 48%.

Хуже того, специалисты компании, похоже, не до конца понимают, причины проблем. Согласно их техническому отчету, «необходимы дополнительные исследования, чтобы понять причину» этих ошибок.

Особая физиологическая чувствительность к музыке, стихам, картинам, когда на пике удовольствия по коже бегут мурашки, может быть заложена в генах и передаваться по наследству, пришли к выводу ученые.

3 марта жителей Земли ожидает первое полное лунное затмение этого года. Почти на час Луна будет закрыта тенью планеты и приобретет характерный красновато-медный оттенок. Ученый Пермского Политеха объяснил природу явления, рассказал, почему Луна меняет цвет, от чего зависит оттенок и где это можно будет увидеть.

Наша тяга к алкоголю может объясняться тем, что мы — потомки фруктоядных обезьян, регулярно питавшихся ферментированными фруктами и даже специально искавших такие плоды, предположили биологи. Так называемую гипотезу о пьяной обезьяне частично подтвердили результаты анализов мочи диких шимпанзе: они показали, что приматы действительно получают этанол из поедаемых ими забродивших фруктов.

Ученые проверили 100 популярных кормов для собак и кошек и во многих из них нашли ПФАС, так называемые «вечные химикаты», причем одни из самых высоких концентраций обнаружили в продуктах на основе рыбы. Во многих случаях их уровень превышает пороги безопасности для людей, установленные европейским регулятором.

Наша тяга к алкоголю может объясняться тем, что мы — потомки фруктоядных обезьян, регулярно питавшихся ферментированными фруктами и даже специально искавших такие плоды, предположили биологи. Так называемую гипотезу о пьяной обезьяне частично подтвердили результаты анализов мочи диких шимпанзе: они показали, что приматы действительно получают этанол из поедаемых ими забродивших фруктов.

В мире оказалось гораздо больше диких пчел, чем кто-либо мог предположить. Ученые впервые оценили, сколько видов пчел существует на Земле, и обнаружили, что показатель превышает 26 тысяч — примерно на четверть больше, чем считалось.

Астрономы недавно проанализировали базу данных о падающих на Землю объектах и пришли к выводу, что два из них прибыли из межзвездного пространства. Известна не только дата, но и место падения каждого из них.

Международная команда палеонтологов описала новый вид динозавра размером с крупную современную птицу. Он носил на голове плотный костяной нарост, который эти животные, возможно, использовали для внутривидовых разборок. Находка показывает, что даже мелкие хищники мелового периода могли решать конфликты не только когтями и зубами, но и ударами головой.

«Любить лишь можно только раз», — писал поэт Сергей Есенин, а герои культовых сериалов приходили к выводу, что «настоящая» влюбленность случается в жизни максимум дважды. Однако ни один из этих тезисов не подкреплен научными данными. Американские исследователи подошли к вопросу иначе: опросили более 10 тысяч человек и вывели среднее число сильных влюбленностей, возможных в течение жизни.

Вы попытались написать запрещенную фразу или вас забанили за частые нарушения.

Понятно

Из-за нарушений правил сайта на ваш аккаунт были наложены ограничения. Если это ошибка, напишите нам.

Понятно

Наши фильтры обнаружили в ваших действиях признаки накрутки. Отдохните немного и вернитесь к нам позже.

Понятно

Мы скоро изучим заявку и свяжемся с Вами по указанной почте в случае положительного исхода. Спасибо за интерес к проекту.

Понятно

Последние комментарии