Уведомления

Авторизуйтесь или зарегистрируйтесь, чтобы оценивать материалы, создавать записи и писать комментарии.

Авторизуясь, вы соглашаетесь с правилами пользования сайтом и даете согласие на обработку персональных данных.

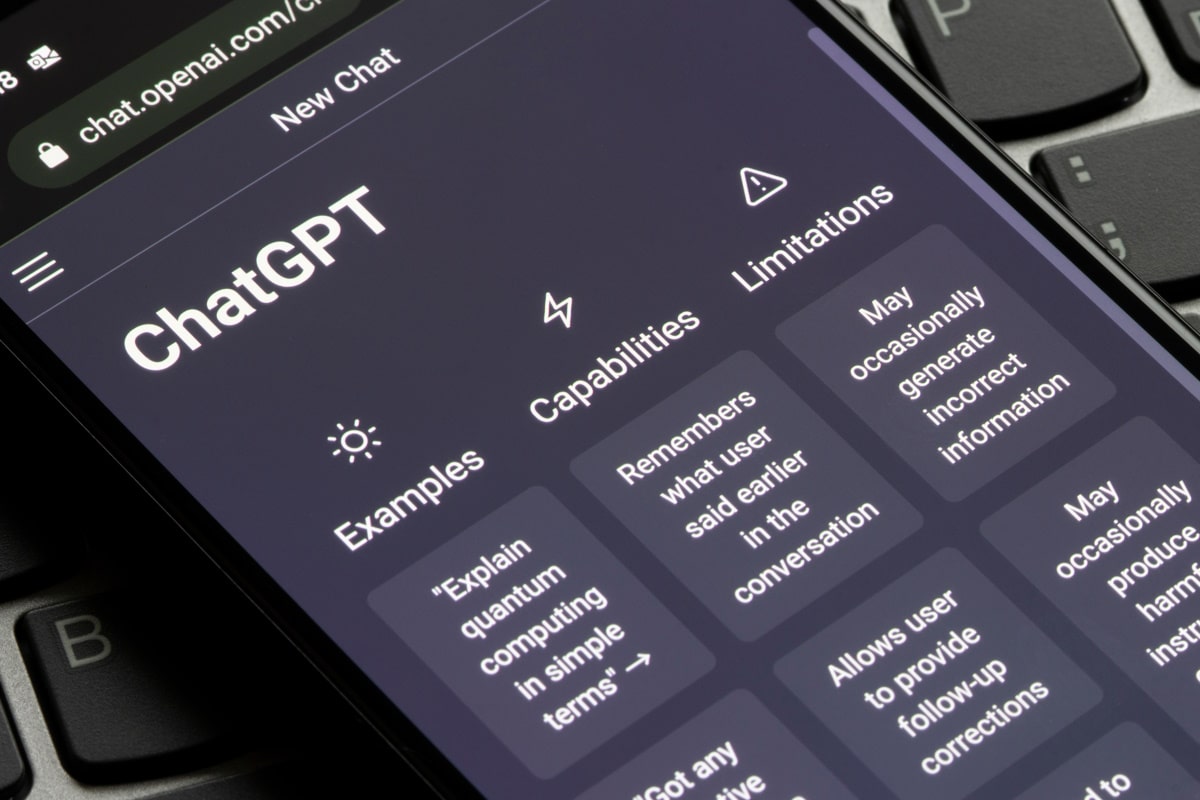

Историк технологий объяснил, почему бесполезно спрашивать нейросети об их ошибках

Когда модели искусственного интеллекта ошибаются и выдают неверный ответ на запрос, пользователи пытаются выяснить причину этой ошибки, задавая вопрос самому ИИ-помощнику. Историк технологий Бендж Эдвардс объяснил, почему делать так нет смысла и как это связано с устройством нейросетей.

Так называемый «искусственный интеллект» стал привычной частью повседневной жизни, качественно выполняя самые разные задачи. Например, авторы недавних научных работ создали ИИ-переводчик со 100 языков, точность которого оказалась на 23% выше, чем у аналогов, а также выяснили, что люди не только путают нейросетевую поэзию со стихами классиков, но и отдают ей предпочтение.

Считая искусственный интеллект напарником, пользователи часто советуются с ним так же, как с помощником-человеком, однако это заведомо проигрышная стратегия. Колонка специалиста в сфере ИИ Бенджа Эдвардса о логике работы нейросетей и их способностях оценивать самих себя появилась в издании Ars Technica.

Прежде всего автор подчеркнул, что стоит помнить: ChatGPT, Perplexity и другие генеративные модели — не то же, что «личности» с определенным типом мышления, системными знаниями и способностями к анализу собственных действий. Это алгоритмы, которые несколько месяцев или лет обучались на огромных массивах данных и тренировались выполнять одну и ту же задачу — генерацию некоторой последовательности (текста, кода на каком-то языке программирования и так далее), соответствующей найденным в обучающих данных закономерностям и запросу пользователя.

При этом нейросеть не работает с запросом как человек. Она делит текст на более мелкие смысловые единицы — токены, а затем каждый токен кодирует исходя из информации о том, как часто он встречается рядом с каждым другим токеном в массиве обучающих текстов. Слова из одной тематической области (например, «компьютер» и «монитор») встречаются рядом чаще, чем слова из разных сфер (допустим, «компьютер» и «помидор»). Соответственно, когда пользователь просит модель искусственного интеллекта ответить на вопрос, она оценивает информацию о токенах, из которых этот запрос состоит, дополняет ею обучающие данные и генерирует ответ, ставя рядом друг с другом те единицы, которые, исходя из статистики, с большей вероятностью сочетаются.

Каждый ответ генеративной языковой модели — не результат вдумчивого анализа содержания запроса или найденных источников, а попытка расположить смысловые единицы так, как они с наибольшей вероятностью располагались бы в обучающих данных. Следовательно, ответить, почему нейросеть сгенерировала что-то, что не соответствует действительности, она не сможет.

Получится ли у искусственного интеллекта проанализировать данные о собственной архитектуре и сделать «выводы» о своих способностях? Скорее, нет. Если вы сформулируете запрос как «Почему ты решила уравнение неправильно?», то нейросеть, не имея доступа к коду, определяющему ее функционирование, сформулирует ответ на основе информации об известных ограничениях предыдущих моделей ИИ. Если же вы добавите в запрос название и версию модели (например, отправите GPT-4o mini следующий текст: «Почему модель GPT-4o mini неправильно решает уравнения?»), то вероятность получить релевантный ответ повысится. Однако он все равно не объяснит ошибку конкретно в вашем уравнении и останется обоснованным предположением, а не результатом саморефлексии.

Кроме того, как отметил Бендж Эдвардс, даже если нейросети обучаются предсказывать собственное поведение при стандартных обстоятельствах (например, «Ты умеешь писать тексты на русском языке?»), то в более сложных ситуациях точность ответов снижается. Получается, что модели искусственного интеллекта могут заявлять о невозможности выполнить задание, которое они выполнить способны, и наоборот — говорить, что легко справятся с задачей, которая им не по силам.

При этом нейросеть необязательно ориентируется только на смысл слов, содержащихся в запросе. Она также может оценивать их стилистические и эмоциональные характеристики и опираться на них. Именно поэтому в ответ на вопрос «Ты только что все уничтожила?» модель с большей вероятностью подтвердит опасения — не потому, что она проанализировала ситуацию и сообщила о собственных действиях, а потому, что сгенерировала текст, соответствующий эмоциональному фону запроса.

Важно также помнить, что ChatGPT и прочие сервисы, в которых пользователь ведет диалог с ИИ-ассистентом, — не отдельные модели, а организованные системы из нескольких нейросетей, каждая из которых в значительной степени «не подозревает» о существовании или возможностях других. Например, компания OpenAI, создавшая ChatGPT, отделяет в этом сервисе модерацию текста от его генерации. Это значит, что модели, создающие ответ, не могут предсказать, что из него удалится на этапе модерации и какие инструменты для этого будут использоваться. Ситуация почти такая же, как если бы мы спросили один из отделов компании о возможностях отдела, с которым он никогда не взаимодействовал.

Таким образом, несмотря на схожесть ответов нейросетей с человеческими, создаются эти два типа текстов совершенно по-разному. Чтобы использовать искусственный интеллект грамотно, стоит помнить о логике его работы.

Удивить разработками космической техники сегодня трудно. И все же есть новшества для орбитальных полетов, выделяющиеся своим необычным замыслом. Может ли работать на орбите воздушный реактивный двигатель? Причем работать неограниченно долго, да еще не требуя топлива. Конечно, нет, скажете вы. Тем не менее такое возможно. Мы расскажем подробнее о самых необычных двигателях для самых перспективных космических орбит.

Приблизительно 4,5 тысячи лет назад в Британии произошла быстрая и масштабная смена населения. Неолитические народы, построившие Стоунхендж и большинство других памятников, практически исчезли, их заменили представители другой культуры. Долгое время археологи спорили, откуда пришли новые люди, которым так быстро удалось покорить остров. Ответ нашла международная команда генетиков.

Ученые впервые показали, как происхождение магических ядер можно вывести напрямую из взаимодействий протонов и нейтронов.

Астрономы недавно проанализировали базу данных о падающих на Землю объектах и пришли к выводу, что два из них прибыли из межзвездного пространства. Известна не только дата, но и место падения каждого из них.

«Любить лишь можно только раз», — писал поэт Сергей Есенин, а герои культовых сериалов приходили к выводу, что «настоящая» влюбленность случается в жизни максимум дважды. Однако ни один из этих тезисов не подкреплен научными данными. Американские исследователи подошли к вопросу иначе: опросили более 10 тысяч человек и вывели среднее число сильных влюбленностей, возможных в течение жизни.

На наземные растения, в основном деревья, приходится 80 процентов всей биомассы Земли, 450 миллиардов тонн сухого углерода и более двух триллионов тонн «живого веса». Поэтому идея сажать новые леса для связывания СО2 из атмосферы долго казалась логичной. Новые данные показали, что реальность заметно сложнее.

Астрономы недавно проанализировали базу данных о падающих на Землю объектах и пришли к выводу, что два из них прибыли из межзвездного пространства. Известна не только дата, но и место падения каждого из них.

Международная команда палеонтологов описала новый вид динозавра размером с крупную современную птицу. Он носил на голове плотный костяной нарост, который эти животные, возможно, использовали для внутривидовых разборок. Находка показывает, что даже мелкие хищники мелового периода могли решать конфликты не только когтями и зубами, но и ударами головой.

Образцы грунта, взятые астронавтами полвека назад, вложили еще один важный кирпич в здание научной картины мира: гипотеза о том, что Земля исходно была сухой, не стыкуется с фактами. Похоже, идею о невозможности сохранения большого количества воды на «теплых» планетах придется пересмотреть.

Вы попытались написать запрещенную фразу или вас забанили за частые нарушения.

Понятно

Из-за нарушений правил сайта на ваш аккаунт были наложены ограничения. Если это ошибка, напишите нам.

Понятно

Наши фильтры обнаружили в ваших действиях признаки накрутки. Отдохните немного и вернитесь к нам позже.

Понятно

Мы скоро изучим заявку и свяжемся с Вами по указанной почте в случае положительного исхода. Спасибо за интерес к проекту.

Понятно

Последние комментарии