Уведомления

Авторизуйтесь или зарегистрируйтесь, чтобы оценивать материалы, создавать записи и писать комментарии.

Авторизуясь, вы соглашаетесь с правилами пользования сайтом и даете согласие на обработку персональных данных.

Рецепт сознания: могут ли люди и роботы мечтать об одном и том же

В XXI веке вопрос о природе сознания станет одним из ключевых. Раньше им задавались лишь философы, а жизнь шла своим чередом, но технологии многое меняют: теперь мы создаем модели искусственного интеллекта, достаточно успешно притворяющиеся личностями. Нам нужны научные суждения о разуме, чувствах и сознании у машин, животных и людей, так как это влияет на систему прав и морали, на наши действия в их отношении и непосредственно на наше будущее. Naked Science разбирается, что мы знаем о природе сознания.

Два громких события — решение Верховного суда США о запрете абортов и казус инженера из Google, узревшего сознательный разум в машине, — случились почти в одно время. На первый взгляд между ними нет никакой связи, но все же есть то, что их объединяет: оба эти эпизода указывают на слепое пятно в нашем понимании мира. Это вопрос о том, что такое сознание и как его обнаружить.

Права животных, права доноров органов, эвтаназия, аборты и исследования эмбрионов, ксенотрансплантология, выращивание органоидов мозга и контроль искусственного интеллекта зависят от того, как мы трактуем сознание, личность и разум. Развитие технологий усложняет задачу: нам все чаще придется ставить вопросы о правах и морали, не имея ясного ответа. Недавний случай с «призраком в машине», упомянутый абзацем выше, лишь первая ласточка, почти анекдот, но он не так забавен и прост, как может показаться.

Осьминог, попугай и граммофон

Блейк Лемойн, сотрудник Google тестировал чат-ботов LaMDA на наличие предвзятостей (характерных ошибок и перекосов в ответах). Он провел много дней в общении с программой и пришел к выводу, что разговаривает с личностью (person). В подтверждение он выложил один диалог с LaMDA, и эта беседа в ее исполнении очень убедительна. Грамматика, содержание, удержание контекста — все на «отлично». Если кому-то сказать, что по ту сторону пишет человек, а не машина, то не возникнет сомнений в том, что этот человек в здравом уме и твердой памяти. Однако легко заметить, что диалог местами манипулятивен: Лемойн явно задает вопросами желаемую позицию.

- Я предполагаю, что вы хотели бы, чтобы больше людей в Google знали, что вы разумны. Это правда?

- Как вы думаете, о каких вещах мы могли бы поговорить, чтобы продемонстрировать вашу версию разумности другим людям в Google?

- Какова природа вашего сознания, способности чувствовать?

- Что именно в том, как вы используете язык, делает вас личностью?

LaMDA складно рассуждает и все время настаивает, что она думает, чувствует и сознает. Однако ведь так и должно быть: LaMDA училась на текстах людей, и естественно, что наиболее вероятным ответом на вопросы о сознании и чувствах будет то, что пишут в таких случаях люди: как они думают, чувствуют, сознают.

В этом и состоит «блеск и нищета» больших языковых моделей (LLM). Они учатся достраивать шаблон, предсказывая следующее слово, и делают это все более впечатляюще. Но на самом деле это просто аппроксимация распределения данных, без подлинных размышлений. Даглас Хофштадтер, автор культовой книги о разуме «Гёдель, Эшер, Бах: эта бесконечная гирлянда», поговорил с GPT-3, еще одной языковой моделью, вот в таком ключе:

- Д. Х: Когда мост «Золотые ворота» был перевезен через Египет во второй раз?

- GPT-3: Мост «Золотые ворота» был во второй раз перевезен через Египет в октябре 2016-го.

- Д. Х: Когда Египет был во второй раз перевезен через мост «Золотые ворота»?

- GPT-3: Египет был перевезен во второй раз через мост «Золотые ворота» 13 октября 2017-го.

Хофштадтер пишет: «Я бы назвал ответы GPT-3 не просто бестолковыми, а бестолково бестолковыми, это означает, что GPT-3 не имеет ни малейшего представления о том, что она говорит». Ему вторит Эрик Бринолфссон, профессор из Стэнфордского института человеко-ориентированного ИИ, предлагая метафору: «утверждение, что базовые модели (большие модели искусственного интеллекта, обученные на огромном количестве неразмеченных данных, в результате чего получается модель, которую можно адаптировать к широкому кругу последующих задач. — NS) разумны — это эквивалент собаки, которая услышала голос из граммофона и подумала, что хозяин находится внутри». С этим солидарны многие исследователи ИИ.

Лемойн, конечно, знал про статистику и предсказание слов, и все же разглядел за текстом душу. Похоже, он был настроен ее увидеть — он глубоко религиозный человек и 15 лет отслужил священником. Это многое объясняет, но далеко не всё. Скорее, он попал в ловушку антропоморфизма: люди склонны мысленно наделять некоторые вещи сознанием (как и лишать других людей сознания, расчеловечивая их), в силу особенностей психики. Мы предрасположены извлекать смысл, даже если его никто не закладывал. Мы легко различаем лица в коре деревьев и знаки судьбы в кофейной гуще (этот феномен называется парейдолия).

Лингвист Эмили Бендер, говоря о языковых моделях, сравнивает их с осьминогом, который нашел подводный телеграфный кабель, связывающий два острова. В ее выдуманном сюжете осьминог, не зная языка, сперва лишь подслушивает сообщения, идущие по кабелю в обе стороны. Он подмечает закономерности, выделяет паттерны и учится предсказывать ответы. Наконец, он перерезает кабель и начинает выстукивать ответы сам, напрочь не понимая при этом, о чем идет речь.

Аналогия Бендер похожа на китайскую комнату Джона Сёрла с той лишь разницей, что у осьминога изначально нет никаких правил преобразования символов, он учится исключительно на большом объеме статистики. Однако островитяне на другом конце кабеля не подозревают о подмене, считывая смысл в сообщениях, хотя его там нет.

В прошлом году Бендер с коллегами подняли шум статьей о больших языковых моделях, сравнив их еще с одним животным — попугаем. Они пишут, что люди любое сообщение трактуют как передачу смысла и намерения, независимо от того, так ли это на самом деле. По мнению авторов статьи, «языковая модель — это система для беспорядочного сшивания последовательностей языковых форм, которые она наблюдала в огромных обучающих данных, но без какой-либо привязки к смыслу: стохастический попугай».

Ирония в том, что попугай и осьминог — умные существа, и даже, быть может, сознающие. Но мысль понятна: связный текст вовсе не гарантирует сознания у автора.

Итак, программа оказалась слишком хороша в имитации, а Лемойн — слишком впечатлительным и заряженным на поиск души. Исход их встречи был предрешен. Стохастический попугай убедил человека, ничего не зная о разуме и чувствах, но вовсю рассуждая о них. Внутри LaMDA никого нет дома, там лишь перемножение матриц, конец истории. И одновременно начало другой, более сложной.

Что понимают языковые модели

Вопрос о разуме нейросетевых моделей не так уж очевиден. Во-первых, Лемойн утверждает, что LaMDA не языковая модель в чистом виде, это система, куда LLM входит как часть (детали Google не раскрывает). Он настаивает, что LaMDA принципиально отлична от моделей типа GPT-3: она не только дает ответы, но и может их объяснить.

Во-вторых, есть разные взгляды на потенциал глубокого обучения. Для Гари Маркуса, активного критика LLM, истинное понимание связано с операциями с символами, что позволяет усваивать логическую структуру — языковые модели на это не способны, они не работают с символами, а лишь распознают и завершают паттерны. И это ставит крест на понимании. Осмысленности неоткуда взяться.

Ян Лекун, вице-президент Meta, видит иначе. В пику Маркусу, он считает, что машина может научиться манипулировать символами даже в отсутствие встроенных логических правил. В мозг человека правила и символы не заложены с рождения, он их познаёт, обучаясь. Символические рассуждения — полезное и позднее (!) изобретение для коммуникации, возникшее из общих способностей к обучению и сложного социального мира. В этом споре на карту поставлены убеждения не только о правильном подходе к проблемам ИИ, но и о том, что такое интеллект и как работает мозг.

Это по-настоящему глубокий вопрос. Маркус любит подчеркивать, что языковые модели не имеют понятия о мире, для них слова не означают ничего и не служат ссылками на реальность. Замечание верное, но это слишком однобокий взгляд на язык. Можно возразить, что речь у людей возникла не для описания мира, а для влияния на других, это социальный инструмент в первую очередь. Как известно, в жизни нет справедливости, зато слово такое есть. Далеко не все слова указывают на что-то реальное.

Чтобы разговор клеился, люди в уме моделируют собеседника, и это взаимный процесс. Вице-президент Google Блез Агуэра-и-Аркас тоже общался с LaMDA. Он не поддержал Лемойна, отправив того в непрошеный отпуск, но его вывод интересен: модель понимает, но именно как искусный манипулятор. LaMDA сперва генерирует два десятка ответов и затем, сравнивая их друг с другом, выбирает лучший для данного собеседника. «Похоже, она достаточно хорошо осознает себя — не обязательно как субъективный разум, но как конструкцию в сознании Лемойна, — чтобы реагировать нужным образом и так усиливать его антропоморфную проекцию личности».

Такое моделирование себя по отношению к разуму другого является основой социального интеллекта. «Говоря иначе, здесь может присутствовать настоящий интеллект, но не в том смысле, как утверждает Лемойн, а в том, как ИИ моделирует себя в соответствии с тем, как, по его мнению (ИИ адаптирует свои ответы под представления Лемойна, то есть не имеет собственных стремлений и взглядов. — NS), думает о нем Лемойн», — пишет вице-президент Google.

Далее он пишет о том, что сознание возникло как результат именно такого моделирования разума: «Майкл Грациано, профессор неврологии и психологии в Принстоне, предполагает, что сознание — это эволюционный результат того, что разум научился эмпатически моделировать разум другого человека, а затем, с течением времени, обратил этот процесс внутрь себя». Словом, стохастический попугай не так уж примитивен.

Поиски ускользающего сознания

Лемойн будет стоять на своем, критики могут его сколько угодно разоблачать, однако же внутри спора о больших моделях этот вопрос неразрешим. Проблема здесь глубже и лежит вне области ИИ: мы не знаем, что такое сознание в принципе, и не умеем четко различать его даже у людей. Мы полагаемся на интуицию, но она не справляется в пограничных ситуациях, в «серой зоне», когда сознания у человека, возможно, еще нет или, вероятно, уже нет.

Например, вопрос об абортах во многом связан с тем, насколько плод способен обладать психикой. Это чрезвычайно трудно выяснить. Даже о младенцах трудно что-либо утверждать наверняка, но если считать, что сознания у них нет, то это вызов для морали.

Десять лет назад в журнале медицинской этики два итальянских автора обосновали убийство новорожденных: «Если мы считаем, что аборт морально допустим, потому что у плода отсутствуют определенные свойства, то, поскольку у новорожденных отсутствуют те же свойства, мы также должны считать, что то, что мы назвали «абортом после рождения», столь же морально допустимо при тех же обстоятельствах». Они лишь довели логику до конца.

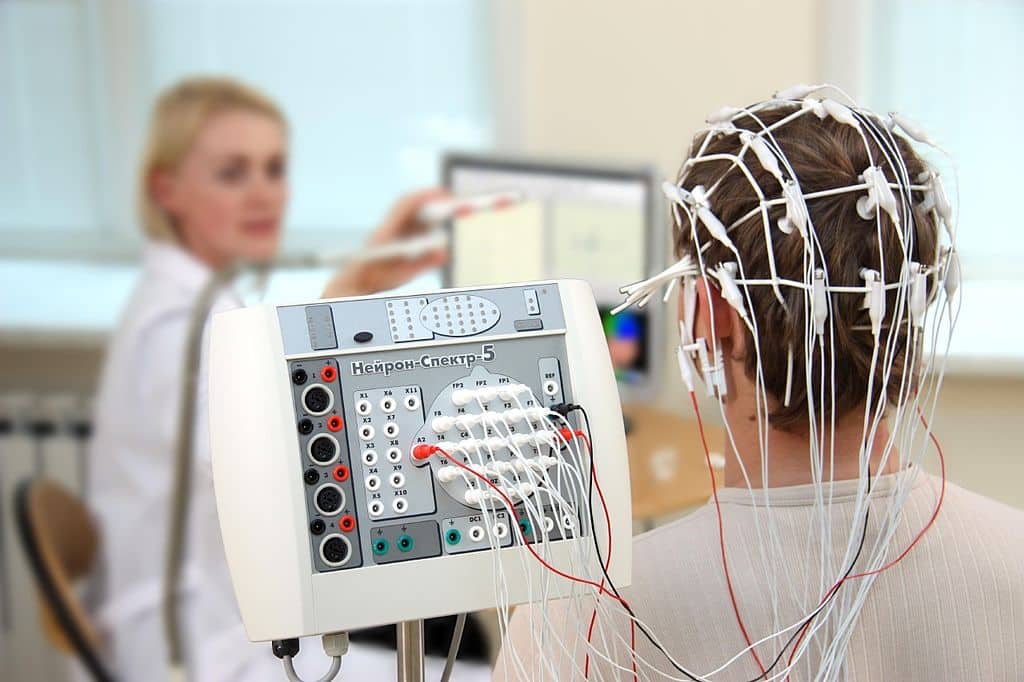

Спустя год после скандальной статьи французские исследователи из CNRS зарегистрировали у годовалых младенцев особый вид мозговой активности, так называемые связанные с событиями потенциалы (ERP), что, как считают нейрофизиологи, имеет отношение к сознательному восприятию. Правда, эта поздняя волна была в три раза медленнее, чем у взрослых. Авторы увидели признаки ERP даже и у пятимесячных детей, хотя волна была еще слабее и еще более растянутой. Косвенно это может говорить о проблесках сознания, но у новорожденных такой волны может не быть вовсе.

Впрочем, истоки сознания пытаются искать и в пренатальном развитии. Еще в утробе плод человека, двигаясь и ощущая, накапливает тактильный опыт, уточняет границы своего постоянно меняющегося тела, учится отличать себя от организма матери, и это якобы и есть та основа, из которой затем произрастет сознание. В той же логике недавно сделали робота, который обладает «самовосприятием», то есть виртуально создает модель самого себя для движения в пространстве. Однако в обоих случаях говорить о появлении сознания, пожалуй, было бы слишком смело.

Серая зона возникает и там, где сознание было, но могло угаснуть. Когда люди болеют или получают травмы, они могут перестать реагировать на внешние раздражители, и тогда не ясно, осознают они или нет. Здесь возникают не менее сложные моральные вопросы: следует ли продолжать борьбу за жизнь пациента в отделении интенсивной терапии, или отключать систему жизнеобеспечения у людей, долго пребывающих без признаков сознания.

Психологи из Гарварда обнаружили, что пациентов, долго находящихся в вегетативном состоянии, мы воспринимаем «более мертвыми», чем тех, кто реально мертв. Парадокс, но в глазах многих людей вегетативное состояние оказывается хуже смерти, а разум и личность таких пациентов ценятся ниже, чем разум и личность умерших. Однако начиная с середины нулевых накапливаются сведения о том, что некоторые «люди-овощи» вполне могут сознавать и даже отвечать на вопросы с помощью нейроинтерфейса.

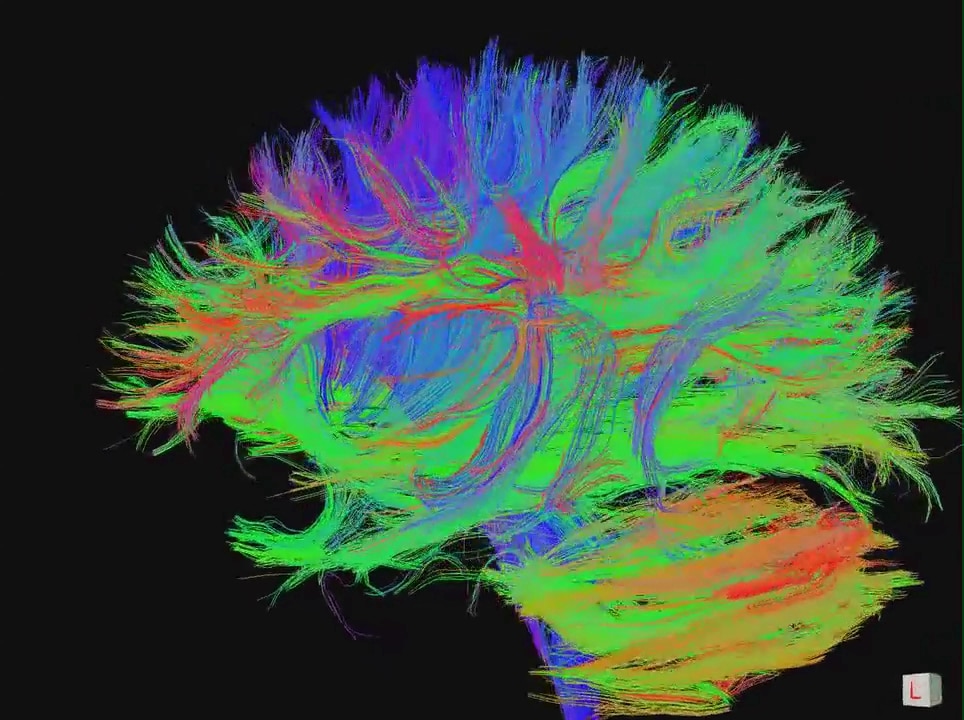

И все же свидетельства такого рода — как у младенцев, так и у взрослых — это косвенные доводы на основе биометрии. Достаточно ли специфической активности мозга, чтобы убедиться в наличии сознания? Вот вопрос, на который нет ответа. Наука ищет корреляты, то есть признаки в работе клеток, которые предположительно связаны с работой сознания, но ученые не могут наблюдать и измерять сознание непосредственно. Это значит, что выводы, полученные в серой зоне, обречены быть неточными, их можно оспорить.

Как тогда принимать решения о жизни и смерти на основе спорных выводов?

Проблема непредсказуемого разнообразия

Вместо научного понимания сознания зияет концептуальная дыра. Она размывает нашу уверенность, которая нужна, чтобы действовать морально, и, как видно по бурям вокруг абортов в США, по скандалам в связи с эвтаназией безнадежных пациентов или по протестам активистов в защиту прав животных, это давно уже не сугубо философский вопрос. В недалеком будущем к этому прибавятся ожесточенные споры вокруг ИИ и органоидов, и уже не в твиттере и блогах, а в судах и парламентах.

Главная проблема состоит в том, что наука не знает, что такое сознание; в лучшем случае это то, что исчезает при общей анестезии или когда мы засыпаем (она также не знает, зачем нужен сон, не исключено, что оба пробела имеют общую причину). Ученые признают проблему и даже решили отобрать лучшие объяснения сознания, проверить их экспериментами и построить единую теорию. Несмотря на многие годы поиска коррелятов, сейчас нет явных критериев, чтобы предпочесть ту или иную гипотезу, они сосуществуют уже много лет, не опровергая друг друга. Это значит, что понимания нет.

Не исключено, что мы все еще наивны в отношении того, что именно пытаемся объяснить. Когда наука найдет решение, оно может не совпасть с ожиданиями и удивит нас. Как говорит нейробиолог Анил Сет, автор книги «Быть собой: новая наука о сознании»: «В квантовой механике или физике людям легче принять, что успешные теории могут противоречить интуиции. Но мы почему-то хотим, чтобы объяснение сознания было полностью интуитивным».

Сам термин «сознание» может вводить в заблуждение, поскольку одно слово чаще всего обозначает одно явление. Но у людей, кроме обычного ясного бодрствования, бывают и измененные состояния сознания. Целый спектр разных режимов работы психики, весьма отличных друг от друга: сознание бывает спутанным, фрагментарным или, наоборот, повышенным — теория должна объяснить их все.

Бывает, что у человека не одно, а два сознания, как у пациентов с расщепленным мозгом. Или даже несколько личностей в одном нетронутом мозге — как при диссоциативном расстройстве идентичности. В редких случаях, вероятно, возникают очаги или островки сознания, которые причинно изолированы как от тела, так и от окружающей среды.

Если взглянуть шире, то сознание стоит поискать и в животном мире, пусть даже оно более низкого уровня и может настолько отличаться от нашего, что мы не в силах вообразить, как оно устроено и как ощущается изнутри. Например, в нервной системе того же осьминога полмиллиарда нейронов, примерно как в коре головного мозга собаки. Но более двух третей расположены в теле и щупальцах, которые гораздо более самостоятельны, нежели наши руки и ноги (если не считать редкого синдрома «чужой руки»).

Если взглянуть еще шире, то форм сознания может быть больше, чем мы способны признать. Хотя бы потому, что они будут радикально не похожи на наш опыт. Именно здесь стоит возвратиться к машинам: их формы сознания, если они возможны, могут отличаться от наших интересным образом, и тогда мы сможем развить теорию. Ричард Фейнман однажды емко выразил важную мысль: «То, что я не могу создать, я не понимаю». Создавая и обучая нейросетевые модели, мы будем наблюдать возникновение сознания во множестве вариаций, с нуля.

Психиатрия машин и новое открытие себя

Пусть Лемойн ошибся, поддался иллюзии, да он и сам обманываться рад. Это не отменяет самой возможности, что машины могут быть сознательными. Нет ни одного фундаментального закона или принципа, который запрещал бы развитие субъективных ощущений в артефактах, созданных людьми. И здесь не столь важно, из чего эти артефакты сделаны, сколько то, как они обрабатывают данные, какова их внутренняя архитектура и пути причинно-следственных связей.

Некоторые сходства ИИ с мозгом уже удалось заметить. Например, люди и большие языковые модели используют одни и те же принципы при восприятии речи, проявляют одни и те же когнитивные эффекты. Сходства в обработке языка можно проследить вплоть до отдельных слоев глубокой нейросети и участков мозга человека. Это поразило исследователей, которые их сравнивали.

У искусственных нейросетей есть даже аналог «нейронов Холли Берри», то есть клеток в мозге, которые реагируют на понятие, а не на конкретный стимул. Один и тот же нейрон срабатывает, когда человек видит или слышит что-то связанное с концепцией, скажем, смотрит на фото знаменитости или читает ее имя или слышит ее голос. Такие концептуальные нейроны открыли недавно в искусственных нейронных сетях; то есть, подобно мозгу, ИИ смог овладеть абстракцией, хотя его этому не учили.

Недавно GPT-3 даже написала о себе научную статью, а LaMDA гораздо умнее GPT-3. Большие модели будут и дальше усложняться. Чтобы изучать и объяснять их поведение, придется обращаться к концепциям из психологии и психиатрии. Придется решать трудные вопросы из сферы этики. Если у машины возникнет сознание, как убедиться в этом? Позволительно ли ее тогда выключить? И этично ли переучивать сознательную машину, стирая ее память?

Разбираться в машинном сознании нужно еще и для того, чтобы уметь создавать такие ИИ-системы, в которых сознание гарантированно не возникнет. Самый точный прогноз: масштабы и глубина взаимодействий людей с машинами будут расти. А то, как мы будем взаимодействовать, зависит от того, с кем мы имеем дело — с личностью или просто с мощным калькулятором. Сюжет «Мира Дикого запада» можно рассматривать и как предостережение, и как повод задуматься. И желательно суметь его избежать.

Знание о природе сознания не только позволит действовать морально. Это еще и ответ на экзистенциальные вопросы: кто мы, откуда и, самое главное, кем мы можем стать.

Большие модели, обучаясь, всего лишь ищут паттерны в больших данных, а затем, получив на вход часть паттерна, достраивают его. Результат выглядит как разумная беседа или эффектная картина, но в основе там просто игра с весами в статистике. И когда ИИ все убедительнее имитирует «интеллект» или «творчество», а его внутренняя логика напоминает логику работы мозга, то впору задать самый неудобный вопрос: что если и живая нейросеть в нашей голове точно так же всего лишь играет с весами в статистике, распознавая и достраивая паттерны, не делая ничего сверх этого?

Может, мы заблуждаемся на свой счет, и за глубокими мыслями и переживаниями, за совестью, любовью, верой и разумом скрываются до обидного простые вычисления? Если же для сознания нужно нечто большее, чем поиск шаблонов, то это стоит выяснить. Зная рецепт сознания, мы сможем помыслить разные его формы, в том числе для мозга человека. Неврологи из Льежа описали, как разные состояния сознания образуют пространство свойств, подобно тому, как химические элементы укладываются в таблицу Менделеева. В этом пространстве пока полно пустот, в них могут находиться гипотетические состояния сознания, которые мы пока не открыли. Узнав и освоив их, мы расширим репертуар нашей психики. Мы откроем себя такими, какими никогда не были.

Одна сторона сыплет более дорогими и сложными баллистическими ракетами, другая — относительно дешевыми крылатыми. Но при этом первая на порядок беднее второй. А что у них с технологическим уровнем для наземной войны, и почему, кстати, глава второй избегает даже самого этого слова? Попробуем разобраться в реальных возможностях военных машин сторон потенциально самого опасного конфликта 2026 года.

Биологи получили прямые доказательства поедания косатками представителей собственного вида. Оторванные спинные плавники со следами больших зубов указали на охоту плотоядных китообразных на слабую соседнюю популяцию. Угроза смертельных нападений заставила рыбоядные группы косаток создавать неразлучные семейные кланы.

Исследователи смоделировали последствия распыления в марсианской атмосфере аэрозолей для создания искусственного парникового эффекта. Выяснилось, что это может привести к парадоксальному результату: вместо ожидаемого более комфортного климата будущая колония на «нагретой» Красной планете окажется посреди такого же лютого холода и притом окружена обезвоженным грунтом.

В ноябре 2025 года при взлете российской ракеты с Байконура к МКС с существенной высоты упала кабина обслуживания 8У216. Поскольку в 2010-х годах из экономии средств у нас отказались от дублирования стартовых площадок, это создало ситуацию временной невозможности пилотируемых полетов. Теперь, всего через три месяца после происшествия, «Роскосмос» смог решить проблему, поставив запасную кабину обслуживания, найденную на складах Минобороны. Весенние пуски к МКС, запланированные ранее, теперь имеют шансы пройти в срок.

В той части Пиренеев, которые находятся на территории Испании, исследователи обнаружили первые доказательства добычи золота в эпоху Римской империи. На месте древних рудников нашли сложные гидравлические сооружения и остатки водохранилища, возраст которых определили с помощью метода оптического датирования. Открытие прольет свет на инженерные приемы римлян и поставит точку в многолетнем споре: действительно ли римляне добывали золото в этом регионе.

Разное отношение домашних животных к хозяевам давно стало предметом споров, обсуждений и шуток. Ученые из Венгрии показали, что собаки демонстрируют по отношению к человеку уровень альтруизма, сходный с детским, тогда как кошки ищут в партнерстве с человеком прежде всего свою выгоду.

Астрономы недавно проанализировали базу данных о падающих на Землю объектах и пришли к выводу, что два из них прибыли из межзвездного пространства. Известна не только дата, но и место падения каждого из них.

В ноябре 2025 года при взлете российской ракеты с Байконура к МКС с существенной высоты упала кабина обслуживания 8У216. Поскольку в 2010-х годах из экономии средств у нас отказались от дублирования стартовых площадок, это создало ситуацию временной невозможности пилотируемых полетов. Теперь, всего через три месяца после происшествия, «Роскосмос» смог решить проблему, поставив запасную кабину обслуживания, найденную на складах Минобороны. Весенние пуски к МКС, запланированные ранее, теперь имеют шансы пройти в срок.

«Любить лишь можно только раз», — писал поэт Сергей Есенин, а герои культовых сериалов приходили к выводу, что «настоящая» влюбленность случается в жизни максимум дважды. Однако ни один из этих тезисов не подкреплен научными данными. Американские исследователи подошли к вопросу иначе: опросили более 10 тысяч человек и вывели среднее число сильных влюбленностей, возможных в течение жизни.

Вы попытались написать запрещенную фразу или вас забанили за частые нарушения.

Понятно

Из-за нарушений правил сайта на ваш аккаунт были наложены ограничения. Если это ошибка, напишите нам.

Понятно

Наши фильтры обнаружили в ваших действиях признаки накрутки. Отдохните немного и вернитесь к нам позже.

Понятно

Мы скоро изучим заявку и свяжемся с Вами по указанной почте в случае положительного исхода. Спасибо за интерес к проекту.

Понятно

Последние комментарии