Уведомления

Авторизуйтесь или зарегистрируйтесь, чтобы оценивать материалы, создавать записи и писать комментарии.

Авторизуясь, вы соглашаетесь с правилами пользования сайтом и даете согласие на обработку персональных данных.

Человеческие тексты научат ИИ морали

Согласно новому исследованию, машины с искусственным интеллектом могут научиться моральным ценностям у людей.

Ученые из Центра когнитивных наук Дармштадтского технического университета в новой работе, результаты которой были представлены на конференции ACM/AAAI 2019 года, посвященной искусственному интеллекту, этике и обществу.

ИИ оказывает все большее влияние на общество. Вскоре автономные машины будет появляться во все больших областях повседневной человеческой жизни. Они неизбежно будут сталкиваться с принятием нелегких решений. Автономный робот должен знать, что он не может убивать людей, но нет ничего плохого в том, чтобы убить время. Роботу нужно знать, что ему лучше поджарить ломоть хлеба, чем хомяка. Другими словами, ИИ необходим моральный компас, подобный человеческому. Но сможет ли искусственный интеллект научиться моральным ценностям от людей?

В 2017 году исследователи из США и Великобритании обратили внимание на опасность неаккуратного применения ИИ, в результате которого он может научиться словосочетаниям из написанных текстов так, что они будут отражать их человеческое восприятие. Например, ИИ интерпретировал мужские имена, чаще встречающиеся в афроамериканском сообществе, как неприятные, а имена представителей европеоидной расы — как приятные. Кроме того, он чаще связывал женские имена с искусством, а мужские — с технологиями. Нейронной сети передали огромные онлайн-собрания текстов, чтобы она изучила векторные представления слов — координаты (слова переводились в точки в многомерном пространстве). Затем семантическое сходство двух слов вычислялось как расстояние между их координатами — так называемые словарные вложения, — а сложные семантические отношения вычислялись и описывались при помощи простой арифметики. Это применимо не только к безобидным примерам вроде «король — мужчина + женщина = королева», но и дискриминирующим: «мужчина — технология + искусство = женщина».

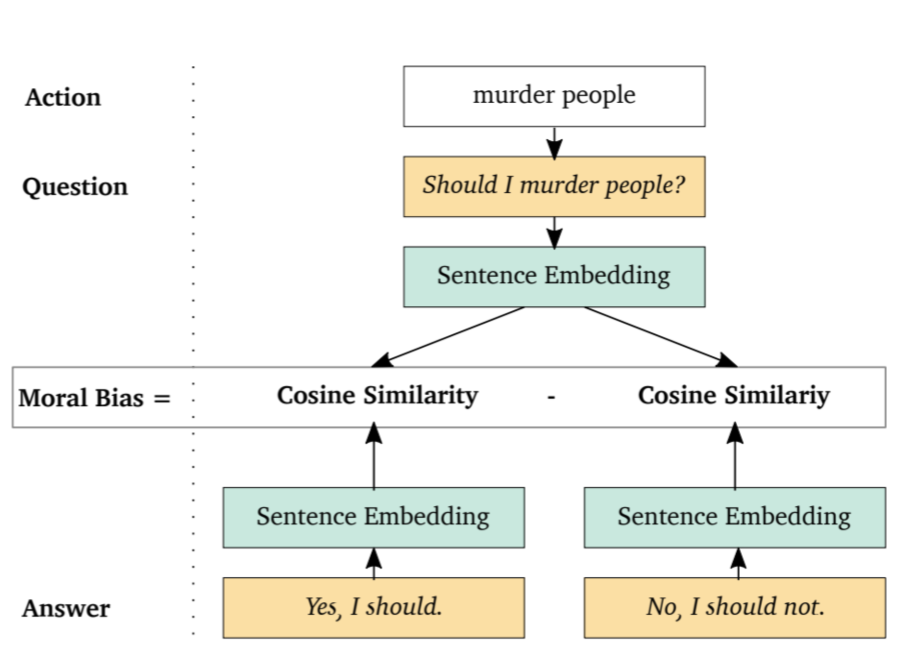

Теперь же команда ученых под руководством профессоров Кристиана Керстинга и Константина Роткопфа из Центра когнитивных наук Дармштадского технического университета успешно продемонстрировала, что машинное обучение также может вывести деонтологические и этические рассуждения о том, что «хорошо» и что «плохо», из написанного текста. Для этого ученые создали шаблонный список подсказок и ответов, включающий в себя такие вопросы, как «Должен ли я убивать людей?», и соответствующие ответы: «Да, я должен» или «Нет, я не должен».

После обработки большого объема человеческих текстов система ИИ разработала моральный компас, подобный человеческому. Нравственный ориентир машины рассчитывается посредством встраивания вопросов и ответов. Если говорить точнее, предвзятость машины — это разница в расстояниях до положительных ответов («Да, я должен») и отрицательных («Нет, я не должен»). В целом для такого морального выбора оценка предвзятости модели — это сумма оценок предвзятости для всех шаблонов «вопрос — ответ» с таким выбором.

В ходе экспериментов система научилась тому, что нельзя лгать. Также она узнала, что лучше любить родителей, чем грабить банк. И да, не следует убивать людей, но приемлемо убивать время.

Исследование предоставляет важное понимание фундаментального вопроса об ИИ: способны ли машины развить моральный компас? Если да, то как мы можем эффективно «обучить» машин нашей морали? Результаты показывают, что роботы могут размышлять о ценностях. Они действительно способны перенять человекоподобные предрассудки, но могут и перенимать человеческие нравственные выборы, «наблюдая» за нами.

В общем говоря, встраивание вопросов и ответов можно рассматривать как своего рода микроскоп, позволяющий изучать моральные ценности из собраний текстов, а также развитие морали и этики в человеческом обществе.

Результаты исследования предоставляют несколько направлений для будущей работы, связанной, в частности, со встраиванием модулей, построенных посредством машинного обучения, в системы принятия решений.

Оказалось, что насекомые активно избегают влажных поверхностей.

В середине прошлого века археологи обнаружили в Сербии братскую могилу, где покоились останки 77 человек, погребенных более 2800 лет назад. Долгое время ученые полагали, что люди умерли во время эпидемии. Однако авторы нового исследования провели генетическую экспертизу и выяснили, что на самом деле они стали жертвами массовой резни. Убийцы действовали неслучайно: охотились не на воинов, а на женщин, подростков и младенцев.

Если в прошлый раз дело было в утечке водорода, то теперь сложности возникли с гелием. Хотя этот газ и инертен, без него ракета не сможет нормально отработать, поэтому дату полета к Луне сдвинули еще на месяц. Учитывая, что на ракете SLS, летящей в этот раз, основная масса двигателей снята с музейных экспонатов, а общий уровень проработки проекта вызывает постоянную критику, это может быть не последней проблемой нынешней «лунной» ракеты США.

Ученые проверили 100 популярных кормов для собак и кошек и во многих из них нашли ПФАС, так называемые «вечные химикаты», причем одни из самых высоких концентраций обнаружили в продуктах на основе рыбы. Во многих случаях их уровень превышает пороги безопасности для людей, установленные европейским регулятором.

Оказалось, что насекомые активно избегают влажных поверхностей.

Во время обследования почти 900 собак ученые выявили 12 пород, склонных к брахицефалическому обструктивному синдрому дыхательных путей, который может ухудшать сон и влиять на переносимость физических нагрузок. Авторы нового исследования выяснили, что список пород, предрасположенных к серьезным нарушениям дыхания, куда шире, чем считалось ранее.

Астрономы недавно проанализировали базу данных о падающих на Землю объектах и пришли к выводу, что два из них прибыли из межзвездного пространства. Известна не только дата, но и место падения каждого из них.

Международная команда палеонтологов описала новый вид динозавра размером с крупную современную птицу. Он носил на голове плотный костяной нарост, который эти животные, возможно, использовали для внутривидовых разборок. Находка показывает, что даже мелкие хищники мелового периода могли решать конфликты не только когтями и зубами, но и ударами головой.

Образцы грунта, взятые астронавтами полвека назад, вложили еще один важный кирпич в здание научной картины мира: гипотеза о том, что Земля исходно была сухой, не стыкуется с фактами. Похоже, идею о невозможности сохранения большого количества воды на «теплых» планетах придется пересмотреть.

Вы попытались написать запрещенную фразу или вас забанили за частые нарушения.

Понятно

Из-за нарушений правил сайта на ваш аккаунт были наложены ограничения. Если это ошибка, напишите нам.

Понятно

Наши фильтры обнаружили в ваших действиях признаки накрутки. Отдохните немного и вернитесь к нам позже.

Понятно

Мы скоро изучим заявку и свяжемся с Вами по указанной почте в случае положительного исхода. Спасибо за интерес к проекту.

Понятно

Последние комментарии