Результаты опубликованы в материалах конференции NeurIPS 2024. Современное машинное обучение часто опирается на обучение моделей на огромных объемах данных, что требует распределенных вычислений. Федеративное обучение (Federated Learning, FL) — это подход, позволяющий обучать модели на децентрализованных данных, хранящихся на множестве устройств (смартфоны, медицинские приборы и так далее), без прямого обмена этими данными.

Ключевая проблема федеративного обучения заключается в высокой коммуникационной сложности. А именно передача данных и вычисление градиентов на основе них (векторов, характеризующих направление изменения параметров модели) становится проблемой, которая замедляет весь процесс обучения. Коммуникационная сложность заключается в огромном количестве передач данных по сети, необходимых для достижения заданной точности решения.

Обычно для решения этой проблемы используют стохастический градиентный спуск. Он основан на том, чтобы использовать неполную информацию для вычисления градиента, выбирая используемые данные для этого случайным образом. такие методы делятся на методы с возвращением и без возвращения. При выборе с возвращением один и тот же набор данных может быть выбран несколько раз, а при выборе без возвращения каждый набор данных выбирается только один раз.

В свежей статье, представленной на конференции NeurIPS 2024, авторы предлагают новые подходы. Они разработали четыре новых алгоритма, сочетающие сжатие градиентов с методом случайной перестановки и локальными вычислениями.

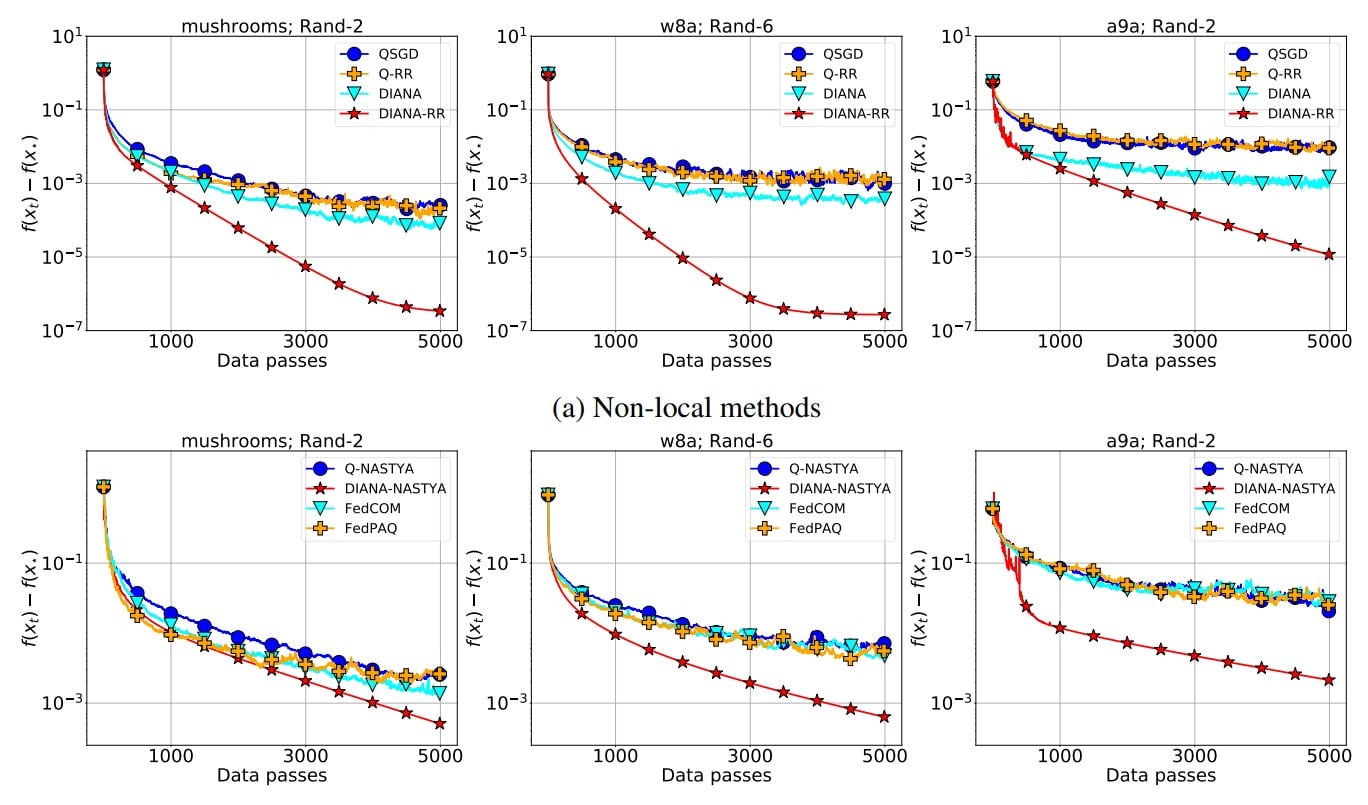

Сравнение алгоритмов Q-RR, QSGD, DIANA и DIANA-RR в задаче обучения глубокой нейронной сети / © NeurIPS 2024

Первый новый алгоритм они назвали Q-RR (Quantized Random Reshuffling). Это самый наивный подход, сочетающий сжатие градиентов и метод перестановки. К сожалению, теоретический анализ показал, что этот метод не демонстрирует преимуществ перед традиционными методами сжатия градиентов.

Второй предложенный учеными метод, названный ими DIANA-RR, является модификацией первого. Они улучшили предыдущий подход, добавив снижение дополнительной дисперсии, которая возникла из-за сжатия градиентов. В результате им удалось получить алгоритм, который имеет лучшую скорость сходимости, чем существующие аналоги, основанные на выборке с возвращением.

Для лучшей адаптации к задачам федеративного обучения ученые расширили алгоритмы Q-RR и DIANA-RR, добавив локальные вычислительные шаги. Так они получили ещё два новых метода, которые назвали Q-NASTYA и DIANA-NASTYA. Эти методы используют разные размеры шагов для локальных и глобальных обновлений. Однако при этом и DIANA-NASTYA, и DIANA-RR предназначены для уменьшения дополнительной дисперсии, вносимой сжатием градиентов.

Авторы исследования провели теоретический анализ и три численных эксперимента, которые подтвердили эффективность предложенных алгоритмов. Алгоритмы DIANA-RR и DIANA-NASTYA значительно превосходят по скорости сходимости существующие методы, особенно при высокой степени сжатия градиентов и в условиях, когда требуется высокая точность.

Для моделирования в первых двух экспериментах авторы использовали решение бинарной проблемы классификации (проверке принадлежности объектов к одному из двух классов) методом логистической регрессии с регуляризацией. В первых двух экспериментах они сравнивали между собой локальные и нелокальные методы.

Оказалось, что результаты, наблюдаемые в численных экспериментах, идеально соответствовали выведенной теории.

В третьем эксперименте авторы использовали нелокальные методы для распределенного машинного обучения глубокой нейронной сети, и в нем новые методы тоже показали свое преимущество над традиционными подходами.

«Многие существующие работы в области федеративного обучения рассматривают методы стохастического градиентного спуска с возвращением. Однако недавно удалось показать как теоретически, так и практически, что методы, основанные на выборке без возвращения, например, метод случайной перестановки, работают лучше», — рассказал Абдурахмон Садиев, научный сотрудник лаборатории численных методов прикладной структурной оптимизации ФПМИ МФТИ.

Разработанные алгоритмы представляют собой важный вклад в область федеративного обучения, позволяя существенно ускорить процесс обучения больших моделей при ограниченных коммуникационных ресурсах. Это открывает новые возможности для применения машинного обучения в различных областях, где важна защита конфиденциальности данных. Дальнейшие исследования будут направлены на оптимизацию алгоритмов и их адаптацию к более сложным задачам федеративного обучения.