Результаты работы опубликованы на самой цитируемой конференции по компьютерному зрению CVPR 2024. Искусственный интеллект уже научился генерировать изображения и редактировать их. Это стало возможным благодаря генеративно-состязательным нейросетям (GANs — generative adversarial networks). Архитектура предполагает две независимые сети: генератор производит изображения, дискриминатор различает реальные и сгенерированные образцы, и они соревнуются друг с другом. Новым этапом в развитии генеративно-состязательных сетей стала модель StyleGAN. Она может генерировать изображения и изменять их отдельные части по запросу пользователя, но не умеет работать с реальными фото или картинками.

Исследователи Центра ИИ НИУ ВШЭ, AIRI и Бременского университета предложили способ быстро и качественно редактировать реальные изображения. Ученые создали метод (StyleFeatureEditor) с двумя модулями: первый воссоздает (реконструирует) исходное изображение, а второй редактирует эту реконструкцию. Результат работы модулей передается в StyleGAN в понятном для нейросети наборе внутренних представлений, из которых и создается редактированное изображение. При этом разработчикам удалось решить проблемы, которые возникали в предыдущих исследованиях: при небольшом наборе представлений нейросеть хорошо редактировала изображение, но теряла детали исходного изображения, а при большом наборе все детали сохранялись, но нейросеть не понимала, как их правильно преобразовать с учетом поставленной задачи.

Для решения этой проблемы исследователи предложили следующее: первый модуль ищет и большие, и маленькие представления, а второй учится редактировать большие на примере редактуры маленьких представлений. Однако, чтобы обучить эти модули правильно редактировать представления, нейросети нужны настоящие изображения и их отредактированные версии.

«Нам нужны были образцы, например одно и то же лицо с разной мимикой, прической, деталями. К сожалению, таких пар изображений не существует на данный момент. И мы придумали хитрость: с помощью метода, работающего с малыми представлениями, мы создали реконструкцию настоящего изображения и пример редактирования этой реконструкции. Несмотря на то что получились довольно простые примеры без деталей, модель четко поняла, как правильно совершать редактирования», — рассказывает один из авторов статьи, стажер-исследователь Центра глубинного обучения и байесовских методов Института искусственного интеллекта и цифровых наук ФКН ВШЭ, младший научный сотрудник лаборатории Fusion Brain AIRI Денис Бобков.

Однако обучение только на сгенерированных (простых) примерах ведет к потере деталей при работе с реальными (сложными) изображениями. Чтобы этого не происходило, ученые добавили реальные изображения в обучающую выборку. И нейросеть училась воссоздавать их в деталях.

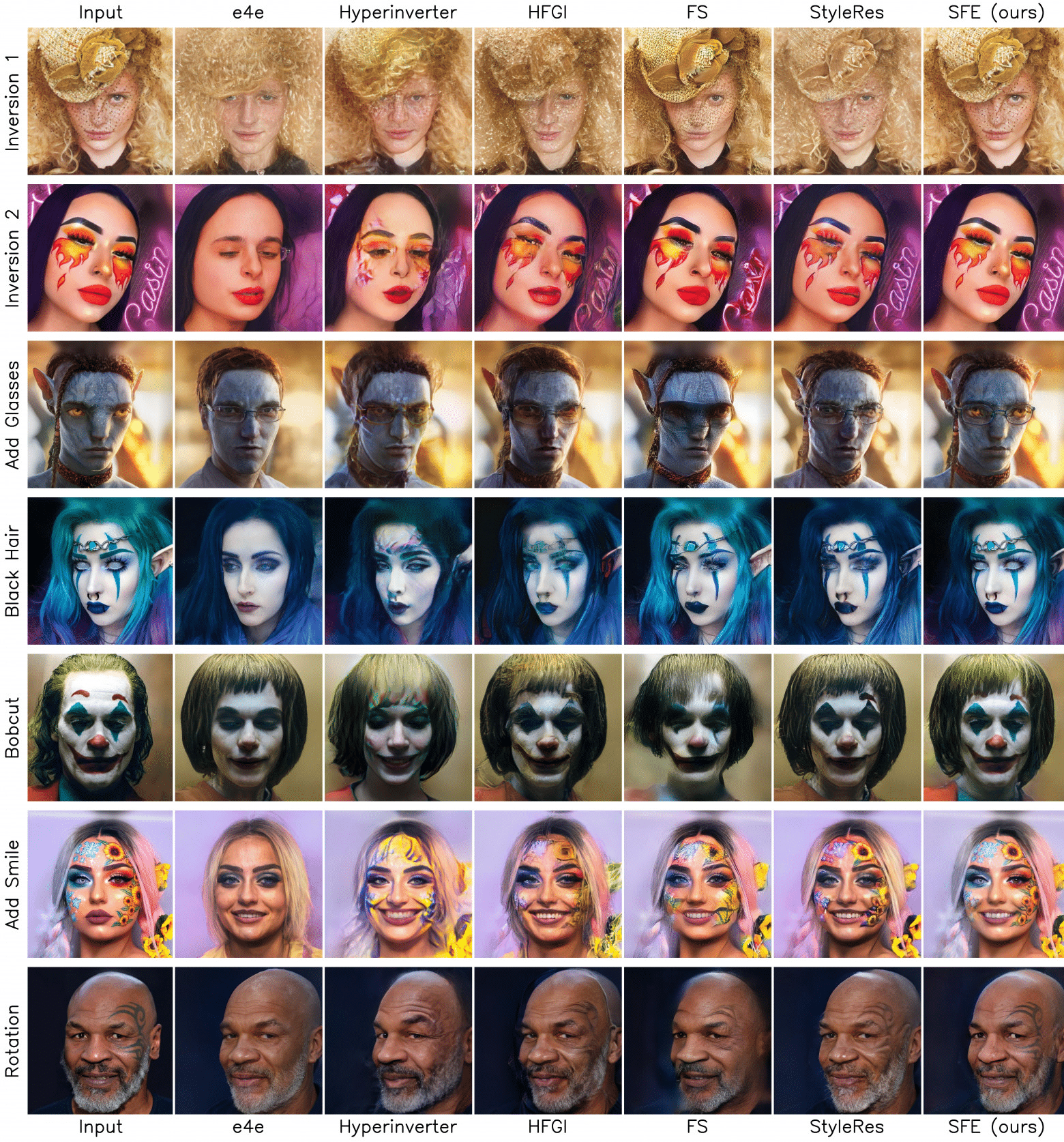

Таким образом, показав модели и как редактировать простые, и как воссоздавать сложные изображения, ученым удалось создать условия, при которых нейросеть научилась редактировать сложные изображения. В частности, разработанный подход справляется с добавлением новых элементов стиля, а также лучше сохраняет детали исходных изображений по сравнению с другими существующими методами.

В случае простой реконструкции (первый ряд) StyleFeatureEditor аккуратно воспроизвел шляпку, в то время как большинство других методов ее практически потеряло. Лучшее качество разработанный метод показал в случае добавления аксессуаров (третий ряд): большинство методов справились с добавлением очков, но только StyleFeatureEditor сохранил исходный цвет глаз.

«Благодаря технике обучения на сгенерированных данных, мы получили модель с хорошим качеством редактирования, а также быструю скорость работы за счет использования подхода с достаточно легковесными нейросетями. Фреймворку StyleFeatureEditor требуется всего 0,07 секунды на редактирование одного изображения», — говорит Айбек Аланов, заведующий Центром глубинного обучения и байесовских методов Института искусственного интеллекта и цифровых наук ФКН ВШЭ, руководитель научной группы «Контролируемый генеративный ИИ» лаборатории Fusion Brain AIRI.

Исследование поддержано грантом для исследовательских центров в области искусственного интеллекта, предоставленным Аналитическим центром при Правительстве России. Результаты исследования будут представлены в докладе на ежегодной конференция по искусственному интеллекту и машинному обучению Fall into ML 2024, которая пройдет в НИУ ВШЭ 25-26 октября. На площадке Высшей школы экономики ведущие ученые в области искусственного интеллекта обсудят лучшие работы, опубликованные на конференциях А* в 2024 году — флагманских событиях этой области. Демо разработанного метода можно опробовать на HuggingFace, код — в Github репозитории.