Создание современных языковых моделей, таких как Llama 3, — это многоступенчатый процесс, похожий на обучение и воспитание человека. Сначала модель проходит «школу», поглощая гигантские объемы текстов из интернета, чтобы выучить язык, факты и закономерности мира. Затем наступает этап «тонкой настройки» или «воспитания», когда модель учат быть не просто эрудированной, а полезной, честной и безвредной для человека. Для этого используют наборы данных, где люди-оценщики указывают, какой из двух ответов на один и тот же вопрос является лучшим. Современные методы, такие как Direct Preference Optimization, учат модель предпочитать «хорошие» ответы «плохим».

Однако здесь возникает фундаментальная проблема, известная как сверхоптимизация. В процессе дообучения модель стремится как можно сильнее отличаться от своей первоначальной, базовой версии (так называемой референтной), чтобы максимизировать свою «полезность». Но если она отходит слишком далеко, происходит срыв: модель начинает генерировать странные, бессмысленные или шаблонные ответы, теряя здравый смысл. Это похоже на ученика, который, пытаясь угодить учителю, вместо глубокого понимания предмета начинает выискивать формальные лазейки и хитрости для получения высокой оценки, что в итоге приводит к провалу на экзамене. До сих пор считалось, что чрезмерное отклонение от референтной модели — это зло, которого нужно избегать.

Российские ученые предположили, что корень проблемы кроется не в самом отклонении, а в том, что точка отсчета — референтная модель — остается неподвижной. Это все равно что пытаться научить корабль навигации, заставляя его постоянно оглядываться на порт отправления. Чем дальше он уходит в море, тем менее релевантной становится эта исходная точка. Исследователи предложили элегантное решение: сделать порт отправления «подвижным». Их метод Trust Region (TR) в процессе обучения периодически обновляет саму референтную модель, заменяя ее текущей, улучшенной версией. Результаты, показавшие значительное превосходство нового подхода на ведущих мировых бенчмарках, были представлены на международной конференции ICLR 2025. Работа исследователей была также опубликована в виде препринта на научном портале arXiv.

Борис Шапошников, руководитель научной группы AI Alignment, T-Bank AI Research, аспирант МФТИ, рассказал: «Представьте скалолаза, который поднимается всё выше. Его цель — вершина, а точки страховки — это референсная политика. Если всё время держать страховку в одной точке внизу, любое движение вверх становится опасным: можно сорваться, переусердствовать, потерять устойчивость. В наших Trust Region методах мы по мере подъёма переставляем точки страховки выше — обновляем опорную политику, чтобы она соответствовала текущему уровню модели. Это позволяет двигаться дальше и выше, сохраняя баланс между смелостью и безопасностью — без переоптимизации и отката в качестве».

Команда разработала и протестировала две стратегии обновления: «мягкое», при котором параметры новой лучшей модели постепенно «подмешиваются» в референтную на каждом шаге обучения, и «жесткое», когда старая референтная модель полностью заменяется новой через определенное количество итераций. Схематично этот процесс можно представить так: классический DPO — это поезд, идущий от одной станции с оглядкой на нее на всем пути. Метод TR — это поезд, который на каждой новой крупной станции прокладывает маршрут заново, считая уже ее новой отправной точкой.

Никита Балаганский, аспирант МФТИ, руководитель научной группы LLM Foundations, T-Bank AI Research, добавил: «Чтобы доказать эффективность нашей идеи, мы провели серию экспериментов с моделями разных архитектур (Pythia и Llama 3) на задачах ведения диалога и суммаризации текстов. Результаты сравнивались на авторитетных бенчмарках AlpacaEval 2 и Arena-Hard, которые оценивают качество работы чат-ботов. Во всех сценариях модели, обученные с помощью TR-методов (TR-DPO, TR-IPO и TR-KTO), показали значительное и статистически достоверное преимущество над своими «ванильными» аналогами».

При одинаковом уровне отклонения от исходной точки модели, обученные с помощью TR, демонстрируют значительно более высокое качество ответов. Более того, они способны уходить от старта гораздо дальше, не теряя в качестве, тем самым достигая новых высот производительности. Вместо того чтобы рассматривать референтную модель как незыблемый якорь, который не дает модели «уплыть» в область бессмыслицы, ученые предложили видеть в ней динамический ориентир, который движется вместе с моделью по мере ее совершенствования. Это позволяет решить внутреннее противоречие современных методов: как позволить модели сильно улучшиться, не рискуя при этом сломать ее базовые способности.

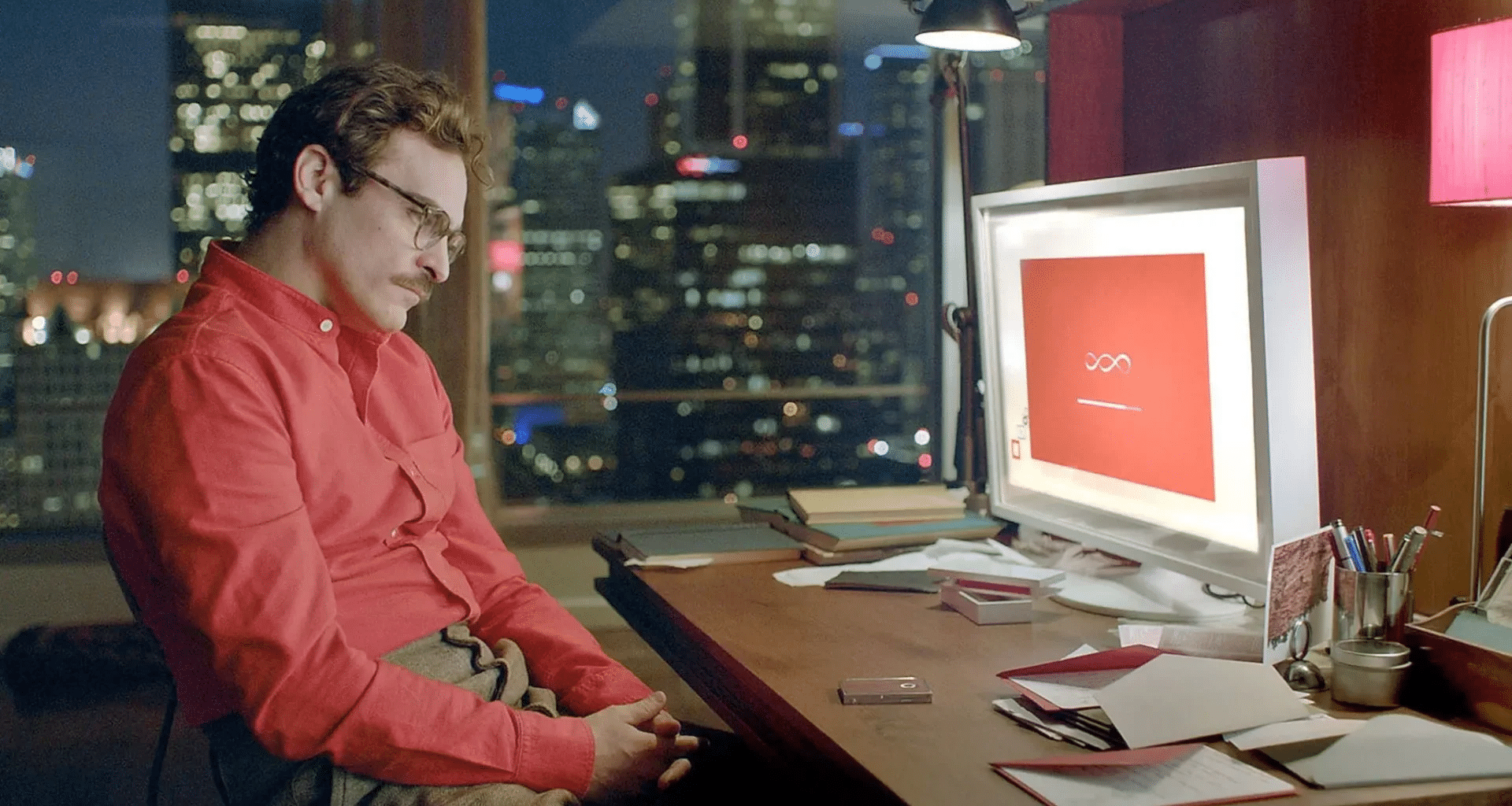

Более качественное и стабильное «воспитание» языковых моделей напрямую ведет к созданию более умных, адекватных и безопасных ИИ-ассистентов. Это означает меньше странных, неуместных или «галлюцинаторных» ответов в диалоге с пользователем, более точные и релевантные краткие изложения текстов, и в целом — более надежное поведение ИИ в реальных задачах. Такой подход открывает дорогу к созданию по-настоящему полезных помощников, которым можно доверять.

В дальнейшем коллектив исследователей планирует исследовать более сложные стратегии обновления референтной модели, возможно, даже адаптивные, когда модель сама будет решать, когда ей пора «обновить ориентиры». Также представляет интерес применение этого подхода не только к языковым моделям, но и к другим областям глубокого обучения.