Если первая квантовая революция начала ХХ века была, по сути, революцией человеческих представлений об устройстве микромира, то стоящая сейчас на пороге вторая квантовая революция — результат синтеза квантовых парадоксов и высоких технологий. Синтез этот, кстати сказать, произошел относительно недавно, каких-нибудь 20-30 лет назад. Правда, первые мысленные эксперименты, демонстрирующие во всей красе парадоксальность квантового мира (то, что действующие в нем законы неприменимы к привычному нам миру «больших» вещей), зародились в результате жарких споров между отцами-основателями квантовой механики еще в 1930-х. Интересно, что споры эти касались не математического аппарата квантовой механики, который к тому времени был практически закончен, а ее попыток истолковать странные законы микромира на привычном нам языке объектов макромира.

Действительно, потребность в интерпретации квантовой механики встает только при ее контакте с окружающим нас макромиром. Иными словами, проблема возникает, когда квантовые объекты начинают взаимодействовать с классическими (например, измерительной аппаратурой в лаборатории), что приводит к коллапсу квантовой волновой функции в одно из возможных классических состояний. Эта так называемая проблема измерения разделила физиков, уже совершивших переход в лоно квантовой теории, на два лагеря.

Первый из них возглавлял Нильс Бор, разработавший с коллегами по Институту теоретической физики в Копенгагене «копенгагенскую» интерпретацию квантовой механики. Центральным положением этой теории было изначально вероятностное описание событий в микромире: что свойства любой квантовой системы неопределенные до того момента, как мы их измерим (то есть пронаблюдаем). При этом до момента измерения квантовая система находится в некой «суперпозиции» всех возможных состояний, а при каждом новом измерении мы можем получать совсем разные значения этих свойств — в зависимости от вероятностей их распределения. Например, электрон в атоме может находиться в суперпозиции двух энергетических состояний и при измерении половину времени испускать фотон с чуть большей энергией, а половину — с чуть меньшей (подробнее о состояниях суперпозиции поговорим ниже).

Противоположную сторону занимал Альберт Эйнштейн, вместе с Эрвином Шрёдингером возглавлявший лагерь физиков, недовольных вероятностным подходом «копенгагенской интерпретации». Эйнштейн с коллегами выражали свой протест, придумывая различные каверзные примеры, демонстрирующие неполноту квантовой механики. Например, известен вопрос Эйнштейна к Бору: «А существует ли Луна, когда на нее никто не смотрит?». И хотя Луна — вполне себе классический объект, не подчиняющийся вероятностным законам квантовой механики, определенная логика в претензиях ученого все-таки была.

А существует ли Луна, когда на нее никто не смотрит?

Продолжив гнуть свою линию в переписке со Шрёдингером, Эйнштейн невольно подтолкнул того к созданию знаменитого мысленного эксперимента с котом. Тот самый злополучный «кот Шрёдингера» был призван показать абсурдность возможности макроскопического объекта — кота — существовать в квантовой суперпозиции состояний («кот жив» и «кот мертв») до тех пор, пока коробка с ним не открыта. Более того, в предложенном им эксперименте Шрёдингер не просто произвольно перенес законы микромира на вполне себе макроскопически-классического кота, но связал того с квантовым объектом — радиоактивным атомом, случайный распад которого и определяет исход эксперимента. В современной терминологии такое состояние называется «связанным» или «запутанным» (entangled).

Казалось бы, какое отношение все эти интерпретации и мысленные эксперименты имеют ко второй квантовой революции? На самом деле, они заложили невероятно мощную теоретическую базу для экспериментов, которые физики смогли воплотить в жизнь лишь полвека спустя благодаря развитию микроэлектроники, информационных технологий и научно-инструментальной базы. Именно этот прогресс позволил проводить манипуляции отдельными квантовыми объектами. Иными словами, к концу 1980-х формирующаяся область нанотехнологий подготовила научный мир к воплощению в жизнь самых смелых квантовых экспериментов, о которых когда-то мечтали Бор, Эйнштейн и Шрёдингер.

Как представить себе квантовое состояние?

Отвлечемся на минуту от течения нашего сюжета и попробуем наглядно представить себе суперпозицию состояний одного кубита: это можно представить в виде сферы, названной в честь нобелевского лауреата Феликса Блоха. На вертикальной оси, проходящей через центр сферы, находятся базисные состояния кубита — вполне себе классические значения 0 и 1, которые получаются при его измерении. Само квантовое состояние суперпозиции задается вектором, проведенным из центра сферы до любой точки на ее поверхности.

Чем ближе к вертикали расположена точка, тем ближе квантовое состояние к одному из классических, а чем ближе к экватору — тем более случайным будет результат его измерения. Фактически измерение квантового состояния кубита заключается в проекции вектора состояния на вертикальную ось или, что эквивалентно, к определению коэффициентов, с которыми базисные состояния входят в суперпозицию . Из-за вероятностного характера квантовой механики такие измерения нужно проводить множество раз, чтобы получить статистически верный результат. Более того, в реальных экспериментах из-за влияния различных шумов обычно получают не единичный, а укороченный вектор, указывающий на одну из точек внутри сферы Блоха, но не дотягивающийся до ее поверхности.

Увы, представить наглядно квантовое состояние для систем из нескольких кубитов гораздо сложнее. Конечно, если они не взаимодействуют между собой, каждый можно представить в виде сферы Блоха, но общее состояние суперпозиции запутанных кубитов так представить не удастся. Для этого прибегают к так называемой матрице плотности, визуализировать коэффициенты которой не составляет большого труда. Процесс измерения этих коэффициентов называется «квантовой томографией» — реконструкцией неизвестного квантового состояния с помощью серии повторных измерений — и служит финальным этапом выполнения любого квантового алгоритма.

Пророческий дар Фейнмана

Вернемся в середину XX века. Заметную роль в зарождении нанотехнологий как самостоятельной области науки сыграл знаменитый физик, нобелевский лауреат и известный популяризатор науки Ричард Фейнман. В конце 1959 года, на встрече Американского физического общества, он прочитал ставшую культовой лекцию «Внизу много места: приглашение войти в новую область физики» («There’s Plenty of Room at the Bottom: An Invitation to Enter a New Field of Physics»). В ней Фейнман обсуждал возможность манипулирования материей вплоть до уровня отдельных атомов, а также создания новых типов микроскопов для исследования наномира, автономных молекулярных машин и крошечных хирургических роботов.

Несмотря на совершенно фантастический (для середины XX века) характер речи Фейнмана, многие его идеи были воплощены в последующие десятилетия. Термин «нанотехнологии» официально вошел в научную терминологию в 1974 году с подачи японца Норио Танигути и был подхвачен американским ученым Эриком Дрекслером, которого часто называют «отцом нанотехнологий». Дело в том, что в 1986-м Дрекслер написал знаменитую книгу «Машины созидания: грядущая эра нанотехнологии» («Engines of Creation: The Coming Era of Nanotechnology»), вызвавшую общественный резонанс и повлиявшую в дальнейшем на создание американской национальной программы по нанотехнологиям. Именно в 1980-х изобрели новые типы микроскопов для исследования и визуализации объектов на наномасштабе: сканирующий туннельный микроскоп (СТМ) и атомно-силовой микроскоп (АСМ). Чуть позже эти инструменты стали использовать не только для наблюдения, но и манипуляции отдельными нанообъектами, вплоть до единичных атомов.

Любопытно, что в 1981 году, 20 лет спустя после своего манифеста о нанотехнологиях, все тот же Фейнман прочел еще одну, тоже ставшую пророческой, лекцию, которая привлекла внимание научных кругов и прочно вошла в историю науки. На этот раз предложенная идея казалась еще радикальнее. Речь шла о создании нового типа вычислительных машин — квантовых компьютеров, работающих по законам квантовой физики и позволяющих использовать всю ее парадоксальную мощь для совершения молниеносно-быстрых вычислений. Примерно в то же время идея квантовых вычислителей появляется в работах американского физика Пола Бениоффа, а также советского ученого Юрия Манина.

Добавление всего одного электрона в квантово-механическую систему (атом, молекулу) усложняет решение описывающего ее поведение уравнения Шрёдингера более чем вдвое

В отличие от коллег, в своей лекции Фейнман делал больший упор не на квантовые вычисления как таковые, а на возможность быстрого и точного моделирования произвольных квантовых систем на квантовых компьютерах (вычисления — любой произвольный алгоритм, придуманный кем угодно, а моделирование — узкий класс задач, которые могут быть решены за счет свойств самой системы). Такое моделирование остается экспоненциально-сложной задачей — что для первых ЭВМ, что для современных суперкомпьютеров. Дело в том, что добавление всего одного электрона в квантово-механическую систему (атом, молекулу) усложняет решение описывающего ее поведение уравнения Шрёдингера более чем вдвое. Соответственно, проводить точные расчеты систем более чем с парой десятков электронов становится крайне время- и ресурсозатратной задачей, хотя такие квантовые системы представляют основной практический интерес, ведь в жизни и в науке мы не только с атомами водорода имеем дело, а со сложными молекулами с большим количеством электронов.

Квантовый компьютер, который в этом случае уместнее называть «квантовым симулятором», может справиться с подобной задачей экспоненциально быстрее. Такой выигрыш в скорости получается за счет того, что в квантовом компьютере все манипуляции по умолчанию производятся с квантовыми объектами — квантовыми битами (кубитами), которые, в отличие от своих классических коллег, не ограничены 0 и 1, но могут одновременно принимать все значения между ними благодаря принципу суперпозиции. А взаимодействующие друг с другом несколько десятков кубитов способны образовывать общее состояние суперпозиции, для классического описания которого не хватит памяти даже самого мощного суперкомпьютера. С другой стороны, такая система кубитов может легко и даже естественно (не нужно добавлять квантовые свойства молекуле как опцию при вычислениях, они у нее и так есть) симулировать поведение атомов или молекул, так как в квантовом симуляторе по умолчанию работают необходимые квантовые эффекты, на расчет которых обычно тратятся большие ресурсы при моделировании этих систем на классических компьютерах.

Пророчество сбывается

Воплотить в жизнь смелые идеи Фейнмана и его коллег оказалось не так просто. Лишь в конце 1990-х ученым удалось поставить первые эксперименты, позволившие контролировать изолированные квантовые системы с достаточной точностью. Тем не менее такое отставание в эксперименте никак не мешало бурному развитию теории квантовой информации и квантовых вычислений в последовавшие за лекцией Фейнмана полтора десятилетия. Благодаря работам нескольких ученых в начале 1990-х появляются первые квантовые алгоритмы — Дойча — Джозы и Бернштейна — Вазирани, — демонстрирующие квантовое ускорение по сравнению с классическими. Чуть позже, основываясь на работах канадца Дэна Саймона, американский теоретик Питер Шор придумывает квантовый алгоритм разложения чисел на простые сомножители.

Алгоритм Шора можно считать некой точкой отсчета, с которой начался массовый интерес к квантовым компьютерам, особенно со стороны различных компаний и государственных подразделений, занимающихся компьютерной безопасностью. Казалось бы, какое отношение разложение чисел на простые множители (факторизация) имеет к кибербезопасности? Дело в том, что для классических компьютеров задача факторизации гораздо сложнее задачи перемножения двух чисел (особенно если эти числа очень большие), и этот факт используется некоторыми алгоритмами шифрования данных.

Один из них, RSA (аббревиатура от имен трех создателей — Rivest, Shamir и Adleman), стал настолько распространенным методом защиты данных, передаваемых по Сети, что сейчас сложно найти сайт или приложение, которые бы его не использовали (например, в составе протокола SSL, необходимого при оплате банковскими картами в интернете). С появлением же алгоритма Шора оказалось, что все эти зашифрованные данные можно достаточно быстро расшифровать, даже не зная ключей шифрования. Остается только собрать сам квантовый компьютер, запустить на нем алгоритм Шора (находящийся в свободном доступе), и любые банковские транзакции или секретная переписка окажутся в вашем распоряжении!

Вот только собрать квантовый компьютер, оказывается, не так-то просто. Около двух десятилетий ученые и инженеры по всему миру потратили, исследуя различные варианты воплощения квантовых битов «в железе». Одними из первых кандидатов в кубиты стали органические молекулы в растворах, ядерным спином которых можно было манипулировать с помощью метода ядерного магнитного резонанса (ЯМР). Первый квантовый процессор на ЯМР, состоящий из двух кубитов, продемонстрировала в 1998 году команда американских физиков. На нем же показали еще один знаменитый алгоритм, выполняющий быстрый поиск по несортированным базам данных, — алгоритм Гровера, опубликованный двумя годами ранее. К началу 2000-х число кубитов в ЯМР-системах увеличилось до семи, и именно на них впервые продемонстрировали работающий алгоритм Шора (впрочем, он смог разложить на множители лишь доступное для манипуляций и первокласснику число 15).

Дальше масштабировать этот подход было затруднительно из-за диффузии и шумов в жидкостях, хотя частично он продолжает развиваться в твердотельных системах (например, дефектах в алмазах). Похожую технологию, использующую в качестве кубитов не ядерные, а электронные спины, реализуют спиновые кубиты на квантовых точках в полупроводниках.

Практически одновременно с ЯМР-кубитами в качестве аппаратной платформы для квантовых вычислений были предложены нейтральные атомы и ионы, захваченные в специальные электромагнитные ловушки. Начав с одного ионного кубита в середине 1990-х, на сегодня такие квантовые процессоры насчитывают уже два десятка полностью взаимодействующих кубитов. Более того, количество атомов и ионов в специализированных квантовых симуляторах, не требующих всеобщего связывания кубитов, перевалило за две сотни. Не считая нескольких нобелевских лауреатов, работающих над развитием этой технологической платформы, в ее пользу говорят и вложившиеся в нее крупные компании (Honeywell, Infineon) и технологические стартапы (ColdQuanta, IonQ, Atom Computing).

Изначально предложенная Фейнманом реализация кубитов на квантах света — фотонах — тоже набирает обороты. До начала 2000-х ее привлекательность сильно понижал тот факт, что фотоны по умолчанию не способны взаимодействовать между собой (при использовании обыкновенных линейных оптических элементов вроде зеркал), однако вышедшая на рубеже веков научная статья породила новую парадигму линейных квантово-оптических вычислений (KLM-протокол — опять же, аббревиатура имен трех авторов). Состояние суперпозиции в этом протоколе возникает за счет того, что фотоны проходят через систему интерферометров, взаимодействуя сами с собой. Вкупе с появившимся десятилетием позже бозонным семплингом, этот подход начал стремительно набирать популярность, подогреваемый развитием интегрированной фотоники на чипе. Список компаний, продвигающих эту технологическую платформу квантовых вычислений, также впечатляет: NTT, PsiQuantum, Xanadu, QuiX, Sparrow Quantum, ORCA Computing и другие.

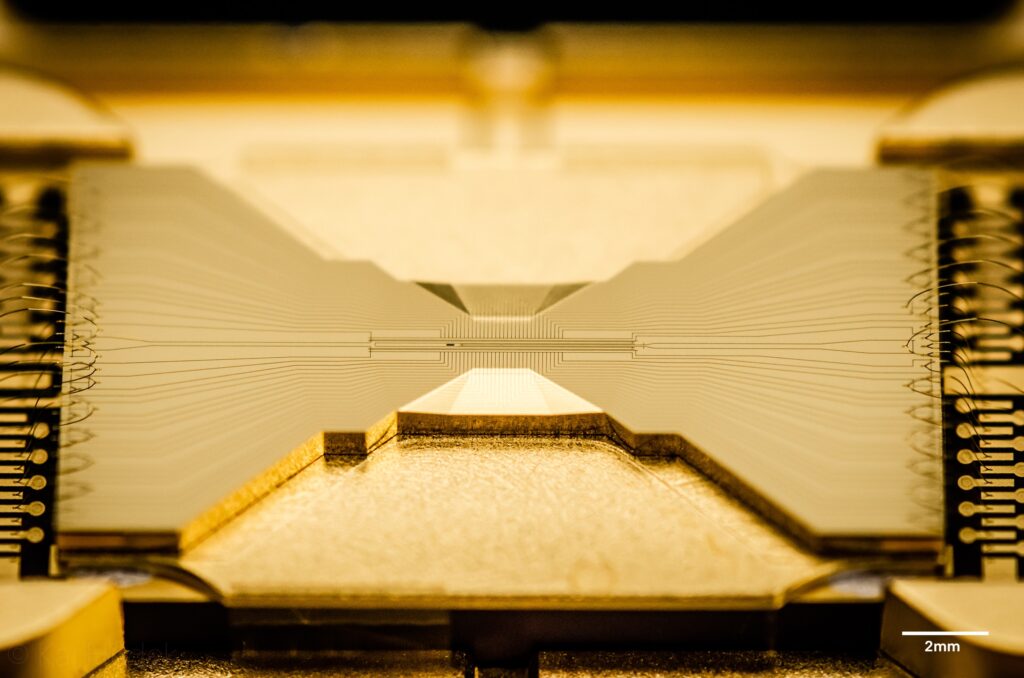

Следующий кандидат на роль идеального строительного блока для универсальных квантовых компьютеров несколько выбивается из перечисленного выше ряда квантовых объектов по одному параметру — размерам. В отличие от поистине квантовых частиц вроде атомов и фотонов, сверхпроводящие кубиты имеют вполне макроскопические размеры, зачастую составляющие доли миллиметра. Возникновение квантовых состояний в таких системах возможно за счет эффекта макроскопического квантового туннелирования, происходящего при протекании тока через небольшой туннельный барьер в сверхпроводящем кольце (джозефсоновский переход, названный так по имени первооткрывателя этого эффекта Брайана Джозефсона). Первые кубиты на основе джозефсоновских переходов были продемонстрированы в 1999 году в Японии, а уже к 2016-му появились квантовые процессоры с десятком сверхпроводящих кубитов.

Подключившиеся к развитию этого направления технологические гиганты вроде Google и IBM к сегодняшнему дню подняли планку до 50 сверхпроводящих кубитов с намерением перешагнуть знаковый барьер в сотню работающих вместе кубитов в ближайшие год-два (теоретически компьютер на 100 кубитах должен быть в тысячу триллионов раз быстрее 50-кубитного, но на практике все чуть сложнее).

Не только количеством кубитов продолжает удивлять стремительно развивающаяся область квантовых вычислений. Улучшаются и характеристики отдельных кубитов, операций между ними (квантовых гейтов), считывания и записи квантовых состояний, а также интерфейсов доступа к кубитам и инструментам для создания квантовых алгоритмов. Запущенная в 2016 году программа IBM Quantum Experience предоставила всем желающим доступ через интернет как к собственным программным симуляторам, так и к реальным квантовым процессорам, что позволило сделать квантовые вычисления несравнимо доступнее для массового использования.

Похожую платную подписку на доступ к своим квантовым ресурсам запустили многие крупные компании, а сама IBM в 2019 году представила первый коммерчески доступный квантовый компьютер на сверхпроводящих кубитах IBM Quantum One (первую такую систему установили в Исследовательском центре Фраунгофера в Германии). С похожими предложениями готовятся выйти на рынок несколько высокотехнологичных стартапов: IQM, Rigetti, Quantum Circuits, Seeqc и другие.

Похожим путем идет и развитие области квантовых технологий в России. Первые практические исследования в этом направлении начались около десятилетия назад, а к настоящему моменту параллельно развиваются сразу несколько перспективных направлений физической реализации квантовых процессоров (сверхпроводники, ионы и нейтральные атомы, фотоны). Такой скачок стал возможен благодаря активной грантовой поддержке, обеспечившей создание современных лабораторий, а также принятию правительством в 2019 году дорожной карты «Квантовые технологии». В рамках этой программы за создание квантового процессора отвечает «Росатом», под эгидой которого собраны лучшие лаборатории и исследовательские центры, уже имеющие экспертизу в этой области.

Когда же ждать появления полноценного квантового компьютера в каждом доме? Или хотя бы в каждом университете? Что мешает их выходу на рынок уже сейчас? На все эти и многие другие злободневные вопросы о квантовых компьютерах и перспективах их применения ответим в следующей статье нашей серии.

Это вторая часть цикла статей про квантовые компьютеры, которые мы делаем в рамках спецпроекта совместно с Homo Science. Первую часть можете прочитать по ссылке.